- Turing Post Korea

- Posts

- AI의 진짜 두뇌를 찾아서 🔍: 엔비디아 독점에 도전하는 칩들의 세계

AI의 진짜 두뇌를 찾아서 🔍: 엔비디아 독점에 도전하는 칩들의 세계

CPU, GPU, TPU, ASIC, APU, NPU - AI를 위한 하드웨어의 세계, 간략히 알아봅시다

이 글은 2025.10.4일 모든 구독자들이 보실 수 있게 공개되었습니다.

들어가며

어쩌면 이젠 어린아이라도 GPU(Graphics Processing Unit)가 뭔지 알 것 같다는 생각을 할 정도로, AI, 그리고 엔비디아는 모두가 아는 이름이 되었습니다. 역시 업계의 리더로서, 엔비디아는 끊임없이 새로운 칩을 선보이면서 기술의 발전을 앞서서 이끌고 있죠. 물론, 다른 영역과 마찬가지로, AI 산업에서 하드웨어는 AI 모델을 구동하고 기술 스택을 작동시키는 핵심 동력이지만, 또 가끔은 걸림돌이 되기도 하는 중요한 요소죠.

그런데, 도대체 왜 모두 GPU에만 집중하는 걸까요? AI 하드웨어의 미래를 이끌, 다른 경쟁자는 없는 걸까요? CPU, TPU도 있지만 그게 전부는 아니겠죠?

여러분들도 특히 우리나라의 리벨리온, 퓨리오사AI 같은 회사에서 생산하는 GPU의 대안을 들어보셨을 겁니다. 그래서, 오늘은, GPU의 틀을 벗어나서 GPU, CPU, TPU라는, 우리에게 가장 잘 알려진 익숙한 세 가지 요소를 넘어서는 다른 가능성들에 대해서 한 번 알아볼까 합니다 - 전세계의 개발자들이 한층 높은 효율성, 그리고 독창적인 접근법을 찾아가면서 열심히 하드웨어를 설계하고 있으니까요.

이 에피소드가 AI 하드웨어의 전반적인 요소와 흐름에 대해 개괄을 할 수 있는 가이드가 되었으면 해서, 먼저 GPU, CPU, TPU라는 세 거인부터 시작해서, 덜 알려지기는 했지만 흥미로운 하드웨어들로 넘어가려고 합니다. 흥미로운 하드웨어들이 어떤 것들이 있나 미리 좀 말씀드리면, Cerebras의 WSE라든가 AWS 하드웨어 같은 맞춤형 ASIC(주문형 집적회로), 그리고 APU, NPU, IPU, RPU, FPGA 같은 것들이죠. 이 글을 통해서 AI 하드웨어의 전체 그림을 한 번 조망해 보실 수 있기를 바랍니다.

오늘 에피소드에서는 다음과 같은 내용을 커버합니다:

CPU, GPU, TPU – 세 가지의 ‘근본’ 하드웨어 설계

흥미로운 AI 하드웨어들 살펴보기 전에, 당연히 먼저 근본이라고 할 수 있는 CPU, GPU, TPU에 대해서 간단히 정리를 해 봐야겠죠.

이 세 가지 하드웨어는 전부 ‘처리 장치(PU; Processing Unit)’로, 소프트웨어 프로그램의 명령을 실행해서 계산을 수행하는 특수한 전자 회로입니다. 많은 분들이 이것들을 컴퓨터 시스템의 ‘두뇌’라고 부르기도 하죠. 이런 처리 장치는, 산술, 논리, 제어, 입출력 작업 등 다양한 연산을 수행해서 데이터를 유용한 정보로 변환합니다.

세 가지 유형의 처리 장치는 각각 서로 성격이 다른 워크로드에 최적화되어 있습니다.

CPU(Central Processing Unit)

중앙처리장치(CPU; Central Processing Unit)라고 부르는 이 CPU는, 일반적인 컴퓨팅, 그리고 순차적인 작업을 실행하기 위해서 개발되었습니다.

CPU는 ‘가장 오래된’ 형태의 처리 장치라고도 할 수 있을 텐데요. CPU의 전신은 1945년에 존 모클리(John Mauchly)와 J. 프레스퍼 에커트 주니어(J. Presper Eckert Jr.)가 선보인 에니악(ENIAC, Electronic Numerical Integrator and Computer)에서 시작됩니다. 에니악은 프로그래밍이 가능한 최초의 전자식 범용 디지털 컴퓨터로, 18,000개의 진공관을 사용해서 다양한 수치 문제를 재프로그래밍(Reprogramming)으로 풀어낼 수 있었습니다.

같은 해에 존 폰 노이만(John von Neumann)의 ‘EDVAC 보고서 초안’이 나왔는데, 여기서 데이터와 명령어를 같은 메모리에 저장하는 개념을 제안했습니다. 이 저장 프로그램 모델이 바로 현대 CPU의 기본 틀이 되었구요.

1950년대 중반, 진공관은 트랜지스터로 대체되었고, 프로세서가 회로 기판에 흩어진 수많은 트랜지스터 기반 부품으로 만들어지면서 컴퓨터가 더 작고, 빠르고, 전력 소모도 적어졌습니다.

1960년대에는 집적회로(IC, Integrated Circuit)가 등장해서 여러 개의 트랜지스터를 하나의 실리콘 칩에 통합하게 되었습니다. 그리고 마침내 1971년, 인텔(Intel)이 세계 최초의 상용 마이크로프로세서인 4004를 출시했는데, 이건 단일 칩에 담긴 4비트 CPU로, 현대적인 CPU의 진정한 시작이었습니다.

Intel 8086은 오늘날의 x86 CPU의 조상이라고 할 수 있고, 현대적인 관점의 ‘효율성을 높이기 위한 최신의 해결책’은 멀티코어 프로세서입니다. 즉, 하나의 칩에 여러 CPU를 포함하는 방식입니다.

그렇다면, 최신의 CPU 안에는 어떤 요소들이 있고 작동은 어떻게 하는 걸까요?

CPU의 핵심에는 전기 신호를 보내서 컴퓨터를 제어하고 데이터와 명령어를 올바른 위치로 보내는 복잡한 회로로 이루어진 제어 장치(Control Unit)가 있습니다. 산술논리장치(ALU, Arithmetic Logic Unit)는 수학, 그리고 논리 연산을 처리하고, 레지스터와 캐시는 프로세서가 자주 필요로 하는 데이터를 저장하는, 작지만 초고속의 저장 공간을 제공합니다.

Image Credit: 위키피디아

CPU에는 코어(Core)도 포함되어 있습니다. 코어는 CPU 내부에 있는 독립적인 처리 장치로, 각각이 명령어를 독립적으로 처리할 수 있습니다. 또 스레드(Thread)는 하나의 코어가 여러 명령어 흐름을 동시에 처리할 수 있게 해줍니다. 이 모든 장치들이 클럭(Clock)의 리듬과 박자에 맞춰서 작동하면서 동기화하게끔 돼 있습니다. 데이터 전송을 위한 버스(Bus), 다음에 실행할 명령어를 추적하는 명령 레지스터(Instruction Register)와 포인터(Pointer) 같은 지원팀 성격의 구성 요소들은, 시스템을 부드럽게 연결해서 명령어가 한 단계에서 다음 단계로 부드럽게 이동하게끔 해 줍니다.

CPU는 ‘간단하지만 강력한’ 사이클로 작동합니다: 가져오기(Fetch) → 해석(Decode) → 실행(Execute)이 바로 그 사이클입니다:

메모리에서 데이터나 명령어를 가져오고,

이걸 하드웨어가 이해할 수 있는 신호로 해석한 뒤에,

필요한 연산(예: 계산, 값 비교, 데이터 전송)을 실행합니다.

현대적인 프로세서에서는 이 사이클이 초당 수십억 번 실행되는데, 여러 개의 코어와 스레드가 병렬로 작동하면서 성능을 높여 줍니다 - CPU는, 마치 잘 조직된 팀처럼 작동하는 셈이죠. 코어 수가 적을 경우(1~2개)는 효율성에 중점을 두게 되고, 코어 수가 많아지면 고성능 작업을 처리하는 데 적합하게 됩니다.

지금 CPU를 만드는 회사들은 주로 이런 회사들입니다:

인텔(Intel): 코어(Core, 소비자용), 제온(Xeon, 서버/워크스테이션용), 펜티엄(Pentium), 셀러론(Celeron, 저가형) 칩을 생산합니다.

AMD: 라이젠(Ryzen, 소비자용/고성능), 에픽(EPYC, 서버용) 프로세서, 그리고 CPU와 GPU를 하나의 칩에 결합한 APU(가속처리장치, Accelerated Processing Unit)를 제공합니다(이것에 대해서는 나중에 더 살펴보겠습니다).

AI 작업과 관련해서 CPU가 가진 중요한 문제는, CPU가 순차적이고 범용적인 작업에 최적화되어 있어서, 대규모의 병렬 행렬 연산에는 GPU나 특수 칩에 비해서 훨씬 느리고 효율이 떨어진다는 점입니다.

자, 이제 하드웨어 타임라인의 두 번째 칩, 바로 유명한 GPU로 넘어가 보겠습니다.

GPU(Graphics Processing Unit)

GPU(그래픽처리장치; Graphics Processing Unit)는 대규모의 병렬 데이터 처리, 그리고 높은 처리량을 감당하는 데 최적화되어 있습니다. 원래 GPU는 이미지와 비디오의 컴퓨터 그래픽을 가속화하기 위해서 개발되었지만, 나중에는 그래픽이 아닌 계산 작업에도 유용하다는 것이 밝혀진 거죠. 이제 GPU는 데이터 집약적인 작업이나 AI 모델 학습처럼 병렬 처리가 효과를 보이는 작업에 널리 사용되고 있습니다.

모두 아시다시피, 오늘날 GPU는 AI의 성능을 좌우하는 중요한 드라이버이고, AI의 계산 능력을 평가하는 핵심적인 기준이 되었죠.

GPU라는 용어는 1999년 엔비디아가 지포스 256(GeForce 256)을 출시하면서 공식적으로 사용되었습니다. 엔비디아는 이걸 세계 최초의 GPU라고 불렀고, 공식적인 GPU의 정의는 ’a single-chip processor with integrated transform, lighting, triangle setup/clipping, and rendering engines(변환, 라이팅, 삼각 설정/클리핑, 렌더링 엔진이 통합된 단일 칩 프로세서)’입니다.

그렇다면, 이 전설과도 같은 GPU는 어떻게 작동할까요?

GPU 내부에는 실리콘 칩에 새겨진 수십억 개의 작은 트랜지스터가 있는데, 이 트랜지스터들은 수천 개의 경량 프로세싱 코어로 구성되어 있습니다. 이 코어들은 복잡한 배선으로 연결되고, 고대역폭 메모리와 캐시가 지원해서 데이터가 빠르게 흐를 수 있게 합니다. 전체 패키지는 보호 재료와 냉각 시스템으로 밀봉되어서 안정성을 유지하구요. (칩의 역사에 대해 더 알고 싶다면 크리스 밀러(Chris Miller)의 ‘Chip War: The Fight for the World's Most Critical Technology’라는 책을 추천합니다. 정말 흥미롭습니다.)

CPU와 다르게, GPU는 병렬 처리에 최적화되어 있습니다. 큰 작업을 수천 개의 작고 독립적인 작업으로 나누어서 여러 개의 코어에 분산, 동시에 계산합니다. 그래서 GPU는 방대한 데이터셋에서 반복적인 행렬 및 텐서 계산이 필요한 AI 모델 학습과 실행에 완벽하게 매치됩니다. GPU의 병렬 구조 덕분에 학습 시간이 몇 달에서 며칠로 줄어들고, 예를 들어서 챗봇 같은 실시간 애플리케이션에 필요한 추론(Inference)도 빠르게 처리할 수 있습니다.

GPU를 만드는 글로벌 리더는, 다 아시는, 엔비디아죠. 이 회사는 CUDA(Compute Unified Device Architecture)라는 병렬 컴퓨팅 플랫폼을 만들어서 GPU 하드웨어를 범용 컴퓨팅에 활용할 수 있게 만들었습니다 - GPU 프로그래밍을 민주화했다고나 할까요?

엔비디아의 주요 AI 인프라 및 산업용 GPU는 다음과 같습니다:

V100(볼타, Volta): Deep Learning Acceleration을 위해서 특별히 설계되었습니다. AI 학습을 위한 행렬 연산을 가속화하는 특수 하드웨어 유닛인 텐서 코어(Tensor Core)를 도입했습니다.

A100(암페어, Ampere): 더 많은 텐서 코어, 더 높은 메모리 대역폭, 그리고 다중 인스턴스 GPU(MIG, Multi-Instance GPU)를 지원합니다. 하나의 물리적 GPU를 여러 논리적 GPU로 나누어서 효율성을 높입니다.

H100, H200(호퍼, Hopper): AI의 산업 표준이라고 할 수 있습니다. H 시리즈는 트랜스포머 엔진(Transformer Engine) 지원, 대규모 메모리 대역폭, 그리고 학습 및 추론을 위한 고속 성능을 제공합니다.

Image Credit: NVIDIA H100 NVL GPU 제품 브리프

블랙웰(Blackwell, 예: B200과 GB200 그레이스-블랙웰 '슈퍼칩')은 수조 개의 파라미터를 가진 차세대 AI 모델을 위해서 설계된 하드웨어입니다. 호퍼(Hopper)의 후속으로, FP4 정밀도(FP4 Precision)를 도입해서 특히 대규모 트랜스포머(Transformer) 작업에서 추론 처리량을 크게 향상시켜 줍니다.

GPU에 이어, 여러 산업에서 AI에 특화된 더 많은 프로세서를 필요로 하게 되면서, 다음의 핵심적인 하드웨어 유형인 TPU가 등장합니다.

TPU(Tensor Processing Unit)

TPU(텐서처리장치; Tensor Processing Unit)는 구글이 신경망 연산, 특히 행렬 곱셈과 머신러닝 워크플로우를 가속화하기 위해서 특별하게 설계한 맞춤형 칩입니다. TPU는 2016년 구글 I/O에서 처음 공개되었고, 그 특성 상 ASIC(주문형집적회로; Application-Specific Integrated Circuit)의 한 종류라고 할 수 있습니다.

TPU의 기본 구조는 다음과 같습니다:

Image Credit: “In-Datacenter Performance Analysis of a Tensor Processing Unit” 논문

핵심 구성 요소는 매트릭스 곱셈 유닛(Matrix Multiply Unit)입니다. 256×256 배열의 곱셈-누산 셀(MAC, Multiply-Accumulate Cell)이 ‘Systolic Array’로 배치되어서, 데이터가 그리드를 통해서 마치 ‘물결처럼’ 흐릅니다.

또, TPU는 대용량 온칩 메모리를 갖추고 있습니다:

중간에 활성화 데이터를 저장하는 통합 버퍼(Unified Buffer, 24MB)

신경망 가중치를 위한 가중치 메모리/FIFO(Weight Memory/FIFO)

합계를 수집하는 누산기(Accumulators, 4MB)

제어 로직, PCIe 인터페이스, 그리고 ReLU나 시그모이드(Sigmoid) 같은 활성화 함수를 위한 활성화 유닛(Activation Unit)은 매트릭스 엔진을 지원하지만, 칩의 대부분은 원시 계산, 그리고 빠르게 데이터를 이동시키는데 이용됩니다.

TPU의 중요한 특징은, 바로 보조 프로세서(Coprocessor)로 작동한다는 점인데요:

호스트 CPU는 PCIe를 통해서 TPU에 명령어를 보내고, TPU는 이를 직접 실행합니다.

TPU의 명령어 세트는 약 12개 정도로 작고, 하드웨어는 모든 것을 파이프라인으로 처리해서 매트릭스 유닛이 항상 바쁘게 작동합니다. 텐서플로우(TensorFlow) 같은 프레임웍은 모델을 이런 로우레벨 명령어로 컴파일합니다.

256개의 작은 온칩 메모리(분산 누산기 RAM, Distributed Accumulator RAM)는 부분 합을 수집하고, Systolic Array가 곱셈-누산(MAC) 연산을 수행합니다. 가중치와 데이터를 Systolic Array로 스트리밍하고 온칩 버퍼에서 로컬로 재사용해서, TPU는 오프칩 메모리 접근을 최소화합니다. 결과적으로, 레이어 단위의 대부분 계산이 칩에서 직접 실행됩니다.

Image Credit: “In-Datacenter Performance Analysis of a Tensor Processing Unit” 논문

좀 복잡한 말씀을 드렸지만, 간단히 요약하면 이렇습니다:

TPU의 각 유닛은 작은 계산을 수행하고 부분적인 결과를 전달하면서 전력을 절약하고, AI 모델의 수학적인 연산을 놀라울 정도로 빠르게 처리합니다. 이 덕분에 TPU는 CPU나 GPU에 비해서 동일한 작업에서 훨씬 적은 전력을 사용하면서도 처리량은 훨씬 높습니다. 구글의 2017년 분석에 따르면, TPU는 당시의 CPU와 GPU(K80급 GPU와 비교한 추론 작업 기준)에 비해서 와트당 약 30~80배 더 높은 성능을 보이기도 했습니다.

자, 그렇지만 이 세 가지 하드웨어 타입 - CPU, GPU, TPU - 은 AI를 움직이는 전체 그림의 일부분일 뿐입니다. 우리는 이 AI 하드웨어 분야의 전체를 한 번 조망하고 싶은 거잖아요?

앞서 TPU는 ASIC 기반 AI 칩의 한 유형이라고 말씀드렸으니, 이 그룹 - ASIC - 에서부터 한 번 시작해 보죠.

ASIC(Application-Specific Integrated Circuits)

ASIC(주문형집적회로, Application-Specific Integrated Circuit)은 특정한 유형의 AI 워크로드를 처리하기 위해서 맞춤으로 설계된 실리콘 칩입니다. 여기에 포함되는 제품을 생산하는 회사들은 보통 하이퍼스케일러 칩 생산자, 그리고 AI 전용 하드웨어를 개발하는 스타트업들이 포함됩니다. 이 섹션에서 빼놓을 수 없는 회사가 Cerebras입니다.

Cerebras WSE(Wafer-Scale Engine)

‘웨이퍼’의 스케일에서 미래를 향해 달리는 세레브라스(Cerebras), 이전에 튜링 포스트에서도 커버한 적이 있는데요:

이 회사의 최신 제품인 Cerebras WSE-3 칩은 지금까지 만들어진 가장 큰 AI 칩 중 하나입니다 - 칩의 면적이 46,255 mm²에 달합니다.

Cerebras WSE-3 칩 사이즈가 요 정도 될 거 같습니다. Image Credit: 도미노 피자

이 회사의 핵심 기술은, Cerebras가 전체 실리콘 웨이퍼를 하나의 칩으로 만드는 기술인데, 이 기술은 CPU나 GPU처럼 웨이퍼를 수백 개의 작은 프로세서로 자르는 기존 방법과는 다릅니다.

WSE-3에는 4조 개의 트랜지스터, 900,000개의 AI 최적화 코어, 그리고 44 GB의 온칩 SRAM 메모리가 들어갑니다. 각 코어는 자체적으로 로컬 메모리를 가지고 있고, 모든 코어가 웨이퍼 전체를 아우르는 초고대역폭 패브릭(Fabric)으로 연결되어 있어서 계산하는 부분과 메모리를 저장하는 부분이 더 가까워집니다.

Image Credit: Cerebras Wafer-Scale Engine (WSE) Datasheet

Cerebras의 웨이퍼 스케일 아이디어가 가져다 주는 결과는 정말 놀랍다고 밖에 할 수가 없습니다:

싱글 WSE-3 칩은 125 페타플롭스(PetaFLOPS)의 AI 계산 성능을 보여줍니다.

Cerebras에 따르면, WSE-3을 웨이퍼 스케일 클러스터(WSC, Wafer-Scale Cluster)로 결합하고, 대규모의 모델 가중치를 위한 오프칩 저장소인 메모리X(MemoryX)와 노드 간 가중치 브로드캐스팅, 그리고 그래디언트 집계를 위한 스웜X(SwarmX)를 통합하면, 수조 개 파라미터 모델을 거의 ‘선형적인 효율로 확장’할 수 있습니다. 이렇게 되면, 전통적인 GPU 클러스터의 복잡한 통신 오버헤드 그 자체를 피할 수 있게 됩니다.

현재 Cerebras WSE에서 실행되는 모델 중 두 가지 두 가지 대표적인 예를 소개합니다:

알리바바(Alibaba)의 Qwen3 Coder 480B Instruct 모델은 WSE에서 초당 2,000 토큰의 속도를 보여줍니다.

전문가 혼합(MoE, Mixture-of-Experts) 모델: Cerebras는 대규모로 이 모델을 훨씬 쉽고 효율적으로 학습시킬 수 있습니다. 이 모델들은 GPU에서 일반적으로 필요한 모델 병렬 처리를 하지 않고도 단일한 장치에서 학습할 수 있습니다. BTA(Batch Tiling on Attention)는 희소 MoE 모델의 계산 비효율성을 해결해 주고, 어텐션은 메모리 부담을 줄이기 위해서 더 작은 타일에서 실행하면서 전문가 네트워크는 코어를 바쁘게 유지하기 위해서 더 큰 유효 배치를 처리할 수 있습니다.

말 그대로, Cerebras의 힘은 그 규모(Scale)에서 나오네요.

AWS Trainium과 AWS Inferentia

아마존도 엔비디아의 ‘GPU 독점’에 대한 대안을 제시하고 싶겠죠 ^.^

역시 어떻게 AI를 위한 하드웨어를 효과적으로 만들 것이냐에 대한 자체적인 비전을 가지고 있습니다. 아마존의 두 가지 자체 개발 칩 역시 AI 워크로드에 특화해서 설계되어 있고, 당연하게도 AWS의 생태계와 깊게 통합되어 있습니다.

AWS Trainium은 모델 학습을 위해서, AWS Inferentia는 추론(Inference)을 위해서 만들어진 칩입니다. 두 칩 모두 내부에 맞춤형 뉴런코어(NeuronCore), 고대역폭 메모리(HBM, High-Bandwidth Memory), 그리고 텐서 연산, 집합 통신(Collective Communication), ‘Sparsity Acceleration’을 위한 전용 엔진을 포함하고 있습니다.

Trainium 2 UltraServer는 64개의 Trainium 2 칩을 탑재해서 희소 모델의 경우 최대 83.2 페타플롭스(Petaflops)의 FP8 계산 성능을, Dense FP8 워크로드에서는 약 20.8 페타플롭스의 성능을 보여줍니다. 엔비디아 H100 GPU의 FP8 계산 성능인 약 4 페타플롭스와 비교하면 우수한 편이라고 보입니다.

AWS Inferentia 2는 대규모 언어 모델과 확산 모델(Diffusion Model)을 배포할 수 있고, 비교군인 EC2/GPU 기반 인스턴스(예: G5)에 비해서 와트당 최대 약 50% 더 나은 성능을 보여줍니다. AWS 하웨어는, 생성형 AI의 요구에 맞춰서 규모, 성능, 비용 효율성을 잘 맞춰서 짜 놓은 솔루션이라고 하면 될 것 같습니다.

자, 맞춤형의 ASIC들을 살펴봤으니, 이제 이름이 ‘…PU’로 끝나고 엔비디아 GPU의 강력한 경쟁자로 포지셔닝하고 있는 하드웨어들을 살펴보러 가시죠.

APU(Accelerated Processing Unit)

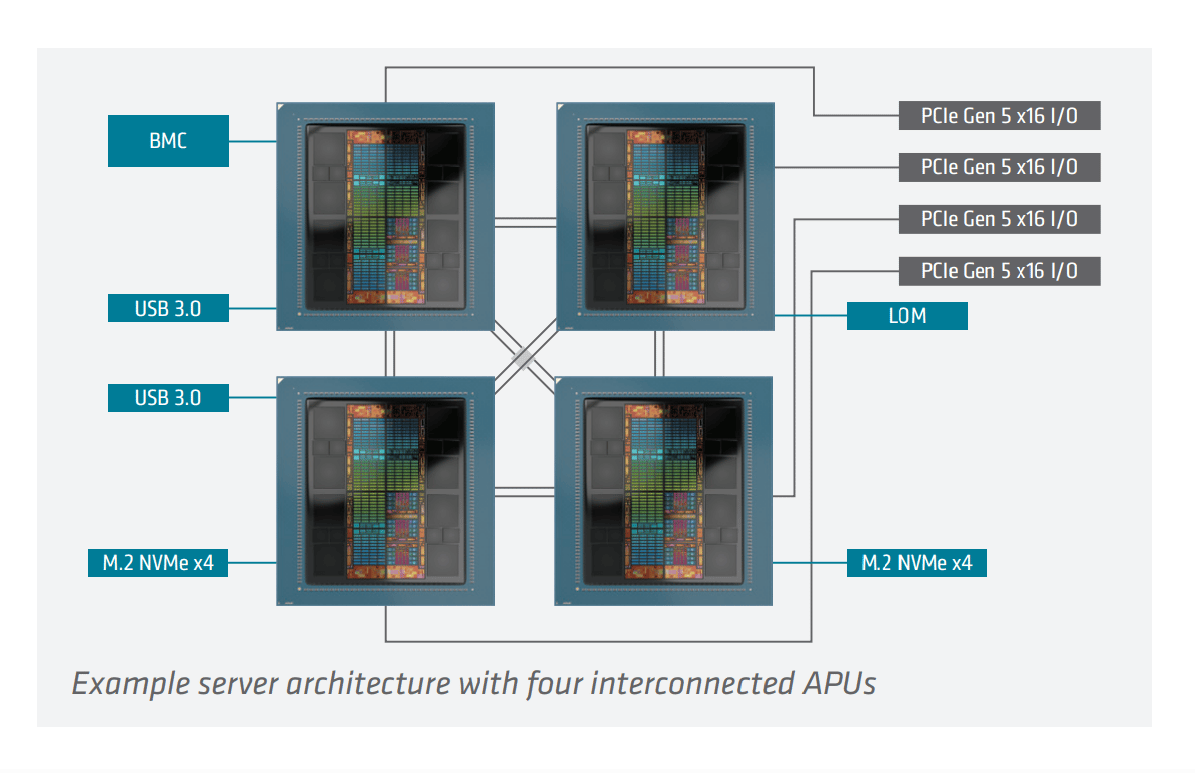

AMD는 CPU와 GPU의 기능을 단일한 패키지에 융합한 혼합 아키텍처의 처리 장치(Processing Unit)를 개발했는데, 이게 바로 APU(Accelerated Processing Unit)로, 별도의 프로세서 간 데이터를 오가는 병목 현상을 제거해 줍니다.

AMD Instinct MI300A는 이런 아이디어를 대표하는 칩입니다. 이 칩은 24개의 ‘젠 4(Zen 4)’ CPU 코어, 228개의 GPU 계산 유닛, 그리고 128GB의 대용량 HBM3 메모리(High-Bandwidth Memory)를 탑재하고 있습니다.

내부적으로는 AMD의 칩렛(Chiplet)과 3D 스태킹 기술(3D Stacking Tech)을 사용해서 제작되었습니다. MI300A의 메모리는 CPU와 GPU 사이에 일관적으로 공유되고, 최대 5.3TB/s의 피크 대역폭을 제공합니다. 다중 칩 아키텍처는 칩렛과 다이 스태킹(Die Stacking)을 활용해서 CPU와 GPU 계산 유닛을 고대역폭 메모리 바로 옆에 배치하고, AMD의 Infinity Fabric과 Infinity Cache로 모든 걸 연결합니다. 이 칩은 모든 주요한 AI 데이터 형식을 지원하고, Sparsity을 위한 하드웨어 지원 기능도 포함하고 있습니다.

Image Credit: AMD INSTINCT™ MI300A APU Datasheet

AMD가 이런 걸 개발했다면, 개념적으로 CPU와 GPU 중 하나를 선택할 필요가 있을까 하는 생각을 엔비디아도 했겠죠? 그렇습니다 - 엔비디아도 이 개념을 적용한 Grace Hopper Superchip을 선보였습니다. 이 통합 모듈은 Arm 기반의 Grace CPU와 Hopper GPU를 엔비디아의 NVLink-C2C 칩 간 연결 기술(NVLink-C2C Chip-to-Chip Interconnect)로 결합한 겁니다. 기본적으로 AMD의 MI300A와 동일한 장점을 가지겠죠:

CPU와 GPU 스레드가 서로의 메모리에 직접 접근할 수 있고,

Atomic Operation을 수행할 수 있고,

동기화를 더 효율적으로 관리할 수 있습니다.

엔비디아에 따르면, Grace Hopper Superchip은 PCIe로 연결된 H100 GPU에 비해서 그래프 신경망(GNN, Graph Neural Network) 학습 속도가 최대 8배 빠르고, CPU만 사용한 베이스라인과 비교해서는 임베딩 생성(Embedding Generation)이 약 30배 빨라졌습니다.

하지만! CPU와 GPU를 결합한 이 방식은 전력 소모가 더 많고, 유연성은 줄어들고, 그리고 제조 과정이 복잡하다는 단점이 있습니다.

자, 그럼 이제 지금까지 살펴본 하드웨어보다 훨씬 더 작은 하드웨어의 세계로 넘어가 보겠습니다.

NPU(Neural Processing Unit)

일반적인 칩 안에, AI 워크로드를 위한 전용의 액셀러레이터가 있다고 상상해 볼까요? 바로 NPU(Neural Processing Unit)가 그 역할을 합니다.

NPU는 현대적인 칩 구조 안에 포함된 작은 엔진이라고 볼 수 있을 것 같고, 신경망, 이미지 및 음성 인식, 나아가서 로컬의 LLM 같은 AI 작업을 실행하기 위해서 특별히 설계된 장치입니다. 인간 뇌의 신경망 구조를 모방한 NPU는 AI 워크로드의 패턴, 즉 많은 행렬 곱셈, 활성화 함수(Activation), 그리고 최소한의 전력으로 빠르게 데이터를 이동시키는 데 최적화되어 있습니다.

현재 실제로 볼 수 있는 NPU의 예시는 너무나 많습니다:

퀄컴의 Hexagon NPU는 스냅드래곤(Snapdragon) 칩에 탑재되어서 스마트폰, 자동차, 웨어러블 기기 등에서 AI 기능을 지원합니다.

애플의 뉴럴 엔진은 2017년 A11 바이오닉 칩(A11 Bionic Chip)에 처음 도입되었는데, 현재 모든 아이폰, 아이패드, 그리고 애플 실리콘을 사용하는 맥에 내장되어 페이스ID, 이미지 처리, 시리(Siri)를 구동합니다.

인텔의 NPU는 새로운 코어 울트라 AI PC 프로세서(Lunar Lake, Arrow Lake)에 포함되어 있고, Windows Copilot+ 기능을 로컬에서 처리하도록 설계되었습니다.

AMD의 XDNA / XDNA 2 NPU는 라이젠 AI 프로세서(Ryzen AI Processor)에 탑재되어서 노트북에서 최대 55 테라옵스(TOPS)의 AI 성능을 제공합니다.

Rebellions의 ATOM NPU는 2023년에 출시된 데이터센터용 AI 가속기로, 스냅드래곤과 유사한 에지 컴퓨팅 및 대규모 추론에 최적화되어 있고, KT의 대형 데이터센터에 배포되어서 컴퓨터 비전, 자연어 처리, 추천 모델 등의 AI 작업을 지원합니다.

Furiosa AI의 RNGD NPU는 2024년에 발표된 칩으로 LLM 및 멀티모달 모델 추론에 사용되고, 180W TDP로 2.25배 더 나은 성능-와트 효율성을 보여주면서 Llama 3 같은 생성 AI 모델을 지속 가능하게 구동할 수 있습니다.

NPU는 온디바이스 추론(Inference)에 아주 적합하지만, 기본적으로는 대규모 언어 모델의 학습이나 아주 무거운 워크로드를 처리할 만큼 강력하지는 않습니다. 또, CPU나 GPU처럼 일반적인 작업을 대체하기는 쉽지 않고, 또 신경망과 무관한 작업을 실행하면 제대로 작동하지 않는 경우가 많습니다. 이렇게 아주 날카롭게 전문화된 영역을 대상으로 한다는 점이, 바로 NPU를 다른 처리 장치(PU)들 사이에서 특별한 존재로 만드는 점이기도 합니다.

기타 유망한 대안적 아키텍처

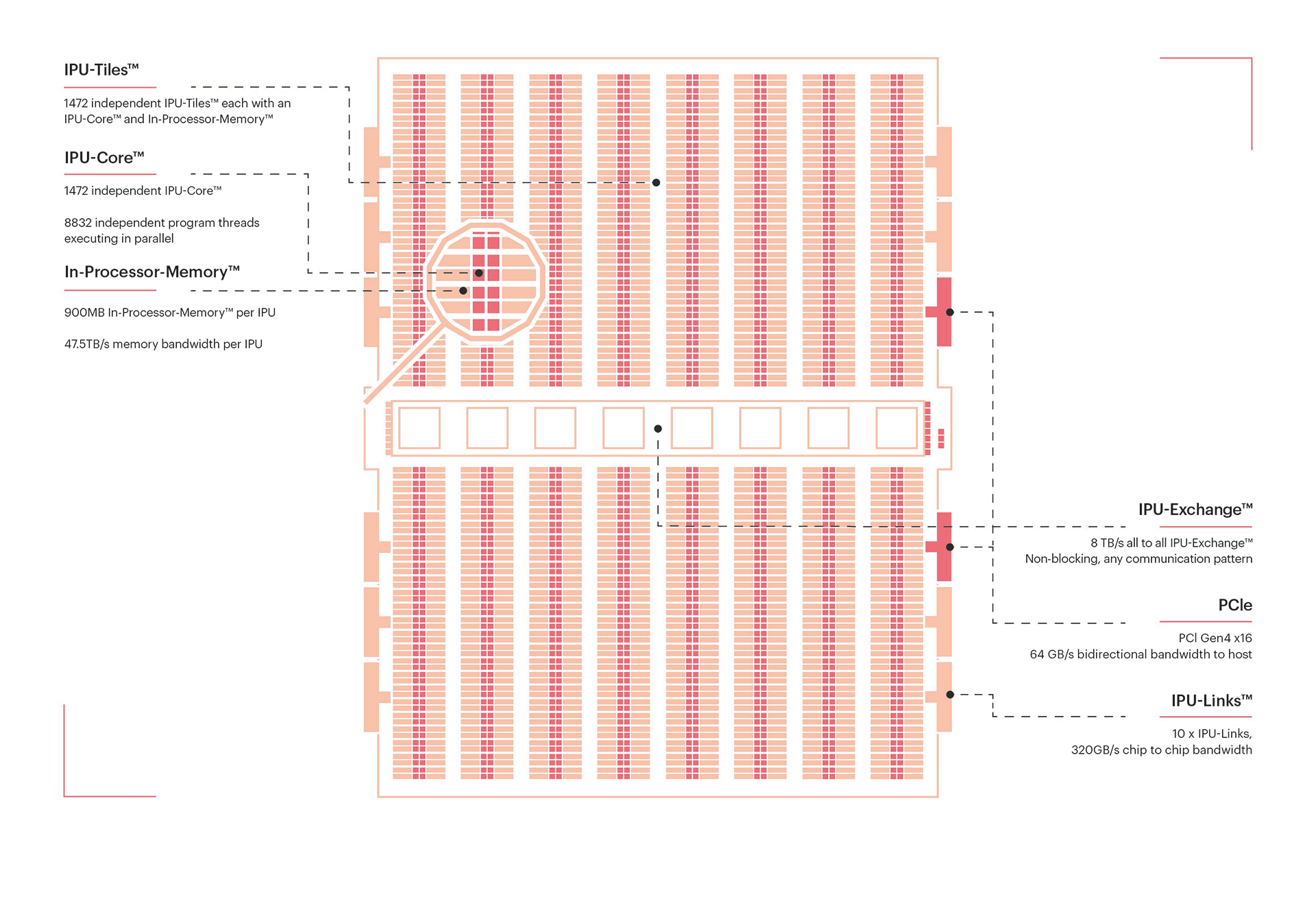

IPU(Intelligence Processing Unit)

그래프코어(Graphcore)의 IPU(Intelligence Processing Unit)는 1,472개의 독립적인 프로세서 코어가 거의 9,000개의 병렬 스레드를 실행하는 대규모 병렬 프로세서입니다. 이 모든 코어가 900MB의 빠른 ‘In-Processor Memory’와 밀접하게 연결되어 있어서, 데이터가 저장된 바로 그곳에서 처리를 할 수 있습니다.

IPU는 머신러닝 워크로드를 위해서 특별히 설계된 구조로, 세밀한 병렬 처리와 온칩 메모리 아키텍처 덕분에 그래프 기반 계산이나 불규칙하고 희소한 워크로드를 처리하는 데 탁월한 성능을 보여줍니다. 그래프 노드 간 연산을 병렬로 실행해서 효율성을 극대화합니다.

Image Credit: the Colossus™ MK2 GC200 IPU, Graphcore IPU 블로그

RPU(Resistive Processing Unit)

RPU(Resistive Processing Unit)는 저항 메모리를 사용한 실험적인 인메모리 컴퓨팅 유닛입니다.

멤리스터(Memristor)나 RRAM(저항랜덤접속메모리, Resistive Random-Access Memory) 같은 기술을 활용해서 메모리 배열 내에서 직접 행렬 연산을 수행합니다. 이런 접근 방식은 데이터 이동을 최소화해서 에너지 소비와 지연을 줄일 수 있겠죠.

2025년에 IBM 연구원들이 ReRAM(Conductive-Metal-Oxide/HfOx ReRAM)을 사용한 아날로그 인메모리 AI 액셀러레이터를 발표했는데, 온칩 학습과 추론을 지원하고, 저전압 스위칭과 멀티비트 용량이라는 특징이 있습니다..

FPGA(Field-Programmable Gate Array)

이 하드웨어는 ‘Reconfigurable AI(재구성할 수 있는 AI)’ 개념에 있어서 특히 중요합니다. 병렬 처리, 메모리, 지연 등을 완전하게 제어하고 싶을 때 말이죠.

GPU나 ASIC과 달리, FPGA(Field-Programmable Gate Array)는 모델의 정확한 요구에 맞춰서 조정할 수 있어서, 아키텍처가 변경되면 나중에 업데이트도 가능합니다.

좋은 예를 들자면, AMD의 Versal™ AI Edge Series Gen 2일 것 같습니다. AMD의 적응형 시스템온칩(SoC, System-on-Chip) 패밀리에 속하는 이 제품은 고전적인 FPGA 프로그래머블 로직을 기반으로 하면서, 같은 다이에 Arm CPU와 특수 AI 엔진(AI Engine)을 통합합니다.

떠오르는 아키텍처

양자 프로세서 (Quantum Processors)

양자 칩은 기존의 비트 대신 큐비트(Qubit)를 사용합니다 - 중첩(Superposition)과 얽힘(Entanglement) 현상을 활용하는 거죠. 이런 특성은 최적화, 검색, 시뮬레이션 작업에서 이론적으로 속도를 엄청나게 높일 수 있는 가능성을 보여줍니다. 하지만 큐비트는 여전히 불안정하고 노이즈가 많아서 현재 양자 컴퓨터는 소규모 문제(Toy Problem)에 적용해 보는 정도로 국한되는 것 아닌가 싶습니다. 현재로서는 GPU나 ASIC을 대체하기보다는 장기적인 ‘문샷(Moonshot)’으로 보입니다.

PIM(Processing-in-Memory) 및 MRAM 기반 칩

AI의 가장 큰 병목 중 하나는 ‘메모리와 계산 유닛 간 데이터 이동’이죠. Processing-in-Memory는 계산을 메모리 배열에 직접 통합해서 이렇게 데이터를 옮기는 과정을 줄입니다.

MRAM(Magnetic Random-Access Memory)은 비휘발성 메모리 기술로, 더 밀도 높고 에너지 효율적인 가속기를 만들 수 있게 해 주는데, 삼성(Samsung)과 미틱(Mythic) 같은 스타트업들이 프로토타입을 실험 중입니다.

PIM은 절대 공상과학이 아닙니다. 앞으로 10년 안에 데이터센터와 엣지 디바이스에 실질적으로 도입될 가능성이 있다고 생각합니다.

뉴로모픽 칩 (Neuromorphic Chips)

뉴로모픽 프로세서는 뇌의 스파이킹 뉴런(Spiking Neuron)에서 영감을 받아서 설계했다고 합니다. 밀도 높은 클럭 기반의 행렬 곱셈 대신, 희소한 이벤트 기반의 스파이크(Event-Driven Spike)를 사용합니다.

인텔의 로이히(Loihi)와 IBM의 트루노스(TrueNorth) 같은 칩은 센서, IoT, 로보틱스와 같은 분야에서 초저전력 지능을 구현하는 것을 목표로 합니다. 하지만 스파이킹 신경망(Spiking Neural Network)을 위한 소프트웨어와 알고리즘은 아직 상당히 미성숙한 상태예요.

뉴로모픽 하드웨어는 저전력 엣지 AI에서 탁월한 성능을 보여줄 거라 기대되지만, 대규모 트랜스포머(Transformer) 같은 워크로드에까지 확장될지는 아직 불확실합니다.

맺으며

자, 지금까지 간략하게나마 정리해 본, 각각의 AI 하드웨어 유형을 전체적으로 보면 이렇습니다:

CPU(Central Processing Unit): 범용 작업을 위한 프로세서.

GPU(Graphics Processing Unit): 병렬 그래픽 및 수학 작업에 특화.

TPU(Tensor Processing Unit): 구글의 AI 가속기.

ASIC(Application-Specific Integrated Circuit): 특정한 AI 워크로드를 위해서 맞춤 설계된 칩.

APU(Accelerated Processing Unit): AMD의 CPU와 GPU 하이브리드.

NPU(Neural Processing Unit): 온디바이스 AI 및 머신러닝 추론에 최적화된 소형 칩.

IPU(Intelligence Processing Unit): 고수준의 세밀한 병렬 처리와 온칩 메모리 아키텍처 제공.

RPU(Resistive Processing Unit): 저항 메모리를 사용한 인메모리 컴퓨팅 유닛.

FPGA(Field-Programmable Gate Array): 병렬 처리, 메모리, 지연을 완전히 제어 가능.

이렇게, 다양한 처리 장치들, 그리고 GPU를 대체할 수 있는 여러 대안들이 AI 산업의 둘러싼 하드웨어 환경을 다채롭게 꾸미면서 미래의 혁신 가능성을 점점 열어가고 있습니다.

최근에는, 많은 대기업들이 AI 하드웨어와 관련해서 새로운 프로젝트를 준비 중이라는 발표도 이어지고 있습니다. 예를 들어서, 엔비디아는 루빈 아키텍처(Rubin Architecture)를 개발 중이고, 메타(Meta)는 자체 칩을 테스트하고 있고, 알리바바(Alibaba)를 비롯한 중국 기업들도 자체 하드웨어 생태계를 구축하기 위해서 AI 추론 칩을 개발하고 있습니다. 앞으로 더 많은 새로운 AI 하드웨어 기술 스택이 등장학 될 것으로 보입니다.

GPU와 CPU를 넘어서는 더 넓은 시각으로 보면, AI 하드웨어 시장이 점점 더 세분화되고 있고, 각각의 플레이어가 자신만의 생태계를 구축하려는 트렌드가 보입니다. 개발자와 기업들에게는 이 확장되는 하드웨어 환경에서 호환성, 소프트웨어 지원, 비용 효율성을 탐색하는 것, 그 자체가 중요한 도전 과제가 되어갈 것 같습니다.

보너스: 참고자료

CPU

What is a central processing unit (CPU)? (IBM 블로그)

Types of central processing units (CPUs) (IBM 블로그)

GPU

What is a GPU and its role in AI? (Google Cloud 문서)

Multi-GPU Workflows (NVIDIA 가이드 문서)

CUDA C++ Programming Guide (NVIDIA 가이드 문서)

NVIDIA Hopper Architecture In-Depth (NVIDIA 블로그)

NVIDIA Blackwell Architecture (NVIDIA 블로그)

TPU

In-Datacenter Performance Analysis of a Tensor Processing Unit (Google 논문, 2017)

TPU architecture (Google Cloud 문서)

An in-depth look at Google’s first Tensor Processing Unit (TPU)

ASIC

APU

AMD INSTINCT™ MI300A APU (Datasheet)

NVIDIA GH200 Grace Hopper Superchip (NVIDIA 블로그)

NPU

IPU

INTELLIGENCE PROCESSING UNIT (Graphcore 블로그)

RPU

FPGA

떠오르는 아키텍처

읽어주셔서 감사합니다. 친구와 동료 분들에게도 뉴스레터 추천해 주세요!

Reply