- Turing Post Korea

- Posts

- 테스트 타임 스케일링(Test-Time Scaling), 지금 주목해야 할 최신 업데이트

테스트 타임 스케일링(Test-Time Scaling), 지금 주목해야 할 최신 업데이트

조심스럽지만 과감하게, 월드 모델·에이전트·디퓨전으로 확장되는 테스트-타임 스케일링 패러다임

들어가며

이 글은 2025.8.30 모든 구독자가 보실 수 있게 공개되었습니다. 재미있게 봐 주세요!

저희 튜링 포스트 코리아에서 올 초, ‘모델의 추론(Inference) 능력’을 한 단계 끌어올리는데 핵심이 된 주요 개념 중의 하나를 깊이 파고들었습니다 - 바로 ‘테스트-타임 컴퓨트(Test-Time Compute)’의 ‘스케일링(Scaling)’ 이야기였죠:

여러분들이 많이 읽어주신 글이었는데, AI 모델의 ‘추론(Inference)’ 단계에서 어떤 일이 일어나는지에 대해 관심을 보여주셨습니다.

한 마디로 말하자면, ‘테스트-타임 컴퓨트’는 모델이 학습 단계를 거친 다음, 지금까지 습득한 능력을 발휘해야 하는 ‘추론’ 단계에서 어떻게 동작할 거냐를 제어하는 핵심 개념이죠. 이 ‘테스트-타임 컴퓨트’를 잘 확장하면, 모델에서 훨씬 더 큰 잠재력을 끌어낼 수 있습니다. 이런 전략은 언어 추론 모델 (LRM; Language Reasoning Model)의 부상을 이끌어냈고, 지금은 에이전트와 함께 주목을 받고 있습니다.

올 초 이후로 ‘테스트-타임 컴퓨트’와 관련된 연구 분야에서 많은 진전이 있었는데요. ‘스케일링을 더 똑똑하게 하는’ 새로운 전략에서부터, 테스트-타임 컴퓨트의 한계, 또 때로 나타나는 단점까지 드러내는 여러 가지 연구들이 이어졌습니다. 아직은 충분히 정리되지 않은 주제이긴 한데, 그 역할은 점점 중요해지고 있다고 봅니다. ‘테스트-타임 컴퓨트’는 모델의 실제 활용 시 성능을 결정짓는 핵심적인 기제로, 멀티모달 시스템, 월드 모델, 에이전트, 그리고 추론 모델의 동작 전반에 대한 논의와 맞닿아 있습니다.

오늘은, 테스트-타임 컴퓨트의 스케일링과 관련해서 최근에 많이 논의되는, 주목할 만한 세 가지 접근 방식을 살펴볼까 합니다:

Chain-of-Layers(CoLa): 추론 모델을 더 잘 제어하고 최적화할 수 있는 방법

MindJourney 테스트-타임 스케일링 프레임웍을 활용해서 VLM(비전-언어 모델; Vision-Language Models)과 월드 모델을 결합하는 방식

TTD-DR: 구글 클라우드가 개발한, 확산(Difussion) 과정을 테스트-타임 스케일링에 적용해서 더 뛰어난 심층 연구(Deep Research) 에이전트를 만드는 방법

그리고, 테스트-타임 스케일링 전략과 반대되는 접근법도 살펴보면서, 어떤 게 잘못될 수 있는지, 그리고 부작용에 대해서 한 번 알아보겠습니다.

오늘 에피소드에서는 다음과 같은 내용을 다룹니다:

테스트-타임 컴퓨트와 스케일링, 잠깐 되짚어보기

아까 말씀드렸지만, 테스트-타임 컴퓨트(Test-Time Compute, TTC)’는 AI 모델이 학습(Training)을 마친 후에 응답을 생성하는 시점에서 사용하는 연산 능력을 뜻합니다. 즉, 추론(Inference) 단계에서 모델을 사용할 때 소모되는 연산 비용이죠. 여기에는 입력을 모델의 여러 레이어(Layer)를 거쳐서 처리하는 것, 단계별 추론(Reasoning Step-by-Step), 그리고 출력을 생성하는 모든 과정이 포함되구요.

테스트-타임 스케일링(Test-Time Scaling)은 ‘추론 단계에서 더 많은 연산을 사용하는 전략’이라고 볼 수도 있습니다. CoT(Chain-of-Thought) 추론 기법을 적용해서 추론의 단계를 늘리거나, 더 큰 컨텍스트 윈도우(Context Window)를 사용하거나, 모델을 여러 번 실행해서 그 결과를 종합하는 등 다양한 실행 기법이 있어요. 이런 접근 방식들은 ‘빠른 응답’보다는 ‘느리지만 더 깊이 있는’, 소위 말하는 ‘성찰적 사고(Reflective Thinking)’를 우선시합니다.

이 전략의 핵심 아이디어는, 모델이 각각의 작업에 대해서 더 ‘열심히’ 처리를 해서 재학습을 하지 않고도 성능을 향상시킬 수 있다는 겁니다. 아래에서는, 이 스케일링 전략을 다양한 모델과 에이전트에 더 스마트하게, 효과적으로 적용할 수 있는 최신의 접근 방식을 살펴보겠습니다.

그럼 먼저, 모델의 추론 길이를 실제로 어떻게 제어할 수 있는지부터 시작해 보겠습니다.

‘제어할 수 있는’ 테스트-타임 컴퓨트

테스트-타임 스케일링(Test-Time Scaling)은 일반적으로 성능을 향상시키기 위해서 더 깊은 모델, 더 많은 레이어(Layer), 추론(Inference)을 할 때 포워드 패스(Forward Pass)를 여러 번 하는 것 등 연산량을 늘리는 걸 의미합니다. 하지만 이 패러다임이 더 광범위하게 사용되면서, 많은 사람들이 이런 원칙을 따르게 되었습니다:

“모든 작업에 항상 더 많은 연산 예산을 써야 할까? 어떤 작업은 굳이 명시적인 ‘생각(Thinking)’이 없이도 더 잘 수행할 수 있는데?”

이런 흐름에 따라서, Claude 4, Qwen3, GLM-4.5 같은 고급의 추론 및 에이전트(Agentic) 모델들은 이미 빠른 응답과 단계별 심층 추론(Step-by-Step Thinking) 간을 전환할 수 있는 기능을 포함하고 있죠.

이런 변화에 맞춰서, 메릴랜드 대학교(University of Maryland) 컴퓨터 과학과 연구팀은 다이나믹하고 적응형(Adaptive)의 ‘사고(Thinking)’에 대한 자체적인 관점을 제시하는 논문을 최근에 발표했는데요. 바로, 모든 입력에 대해서 모델 전체를 동일하게 고정된 형태로 사용하는 대신, 입력마다 모델의 깊이(Depth)와 레이어 구성을 조정하는 방법을 ‘추론 단계에서 탐구’한 겁니다.

이 접근 방식은, 더 어려운 문제에는 레이어를 반복 실행해서 더 많은 연산을 하고, 더 쉬운 문제에 대해서는 레이어를 건너뛰면서 연산량을 줄이는 방식을 취합니다. 이걸 Test-time Depth Adaptation이라고 부릅니다. 그리고 이걸 실제로 구현하기 위해서 CoLa(Chain-of-Layer)라는 기법을 제안했습니다.

이런 생각은, 단순하게 접근해 온 테스트-타임 스케일링에 대한 일종의 도전이면서, ‘레이어를 스마트하게 사용하면, (종종) 더 적은 연산을 해도 더 나은 결과를 얻을 수 있다’는 것을 보여줍니다.

그럼, 이제 그 작동 방식에 대해 살펴보시죠.

Chain-of-Layers(CoLa) 기법

메릴랜드 대학교 연구진의 핵심 아이디어는, 사전 학습된(Pretrained) 모델을 재학습하지 않고 테스트-타임에 더 똑똑하게 만드는 것입니다. 이걸 하기 위해서, 연구자들은 모델의 레이어(Layer)를 재배열할 수 있는 블록처럼 다룹니다. 그리고 각각의 테스트 예제마다, 이 블록들을 사용해서 해당 입력에 맞는 맞춤형(Custom) 모델을 구성합니다. 이렇게 입력마다 유연하게 모델을 구성하는 방식을 CoLa(Chain-of-Layers)라고 부릅니다.

CoLa를 사용하면 아래와 같은 일을 할 수 있습니다:

더 빠르고 단순한 작업에는 레이어를 건너뛰기(Skip)

더 깊은 사고(Deeper Thinking)를 흉내 내기 위해서 레이어를 반복적으로 재사용(Recurrent Reuse) — 마치 RNN처럼요

레이어 순서를 바꿔서 더 유용한 조합(Composition) 찾기

각각의 입력에 맞는 최적의 맞춤형 레이어 구성을 찾기 위해서, 연구자들은 몬테카를로 트리 탐색(Monte Carlo Tree Search, MCTS) 방식을 사용했습니다. MCTS는 다양한 테스트-타임 컴퓨트 최적화 접근법, 그리고 게임 AI(알파고와 같은)에서 자주 사용하는 인기 있는 탐색 기법 중의 하나입니다. MCTS의 가장 큰 장점은 탐험(Exploration, 새로운 아이디어 시도)과 활용(Exploitation, 이미 잘 작동하는 것 사용) 사이의 조화를 균형있게 잡는다는 점입니다.

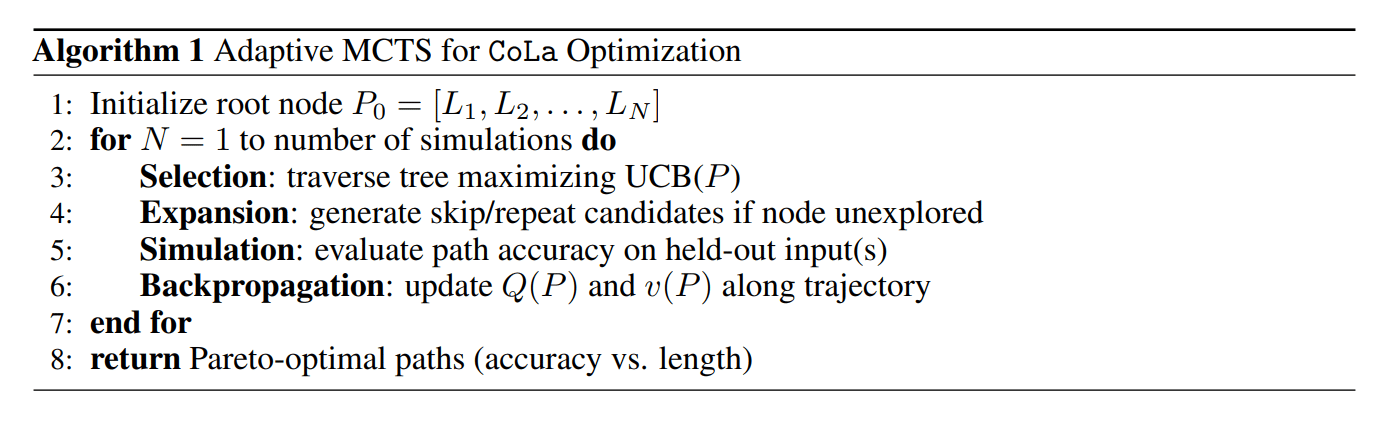

Image Credit: CoLa 오리지널 논문

CoLa 기법에서, MCTS는 서로 다른 레이어 경로를 시도해 보면서 가능한 한 적은 레이어로도 정확한 예측을 만들어 내는 경로를 탐색하는데요. 그 작동 방식은 다음과 같습니다:

각각의 상태(State)는 부분적 또는 완전한 레이어 시퀀스(Sequence)를 나타냅니다. 시작점은 원래 모델의 경로입니다.

액션(Action)은 해당 시퀀스를 변경할 수 있습니다. 예를 들어, “레이어 k개 건너뛰기(Skip k Layers)”, “레이어 k개를 r번 반복하기(Repeat k Layers r Times)” 같은 방식이고, 여기서 k와 r은 1에서 4까지의 값을 가질 수 있습니다.

Image Credit: CoLa 오리지널 논문

경로(Path)가 완성되면, 모델은 해당 경로를 입력에 적용해서 출력을 생성합니다. 출력이 정답이면 보상(Reward) 1점을 부여하고, 너무 많은 레이어를 사용한 경우에는 효율성을 장려하기 위해서 페널티(Penalty)를 차감합니다.

다음에 탐색할 경로를 선택하는 점수 함수로는 UCB(Upper Confidence Bound)를 사용하고, 아래와 같은 역할을 합니다.

과거 성능이 좋은 경로를 장려(활용, Exploitation)

방문 빈도가 낮은 경로를 탐험(Exploration)

긴 레이어 경로에 페널티를 부여해서 더 짧고 효율적인 모델을 선호

탐색이 끝나면 알고리즘은 파레토 최적(Pareto-Optimal) 집합을 선택합니다 - 정확도와 효율성 간의 최적의 균형을 제공하는 해법들이죠. 최종적인 결과는 이렇게 구성된 ‘맞춤형 CoLa(Chain-of-Layers)’입니다.

이 모든 과정에서 모델의 파라미터(Parameter)는 변하지 않고, CoLa는 단지 사전 학습된 레이어를 더 지능적으로 활용할 뿐인 겁니다.

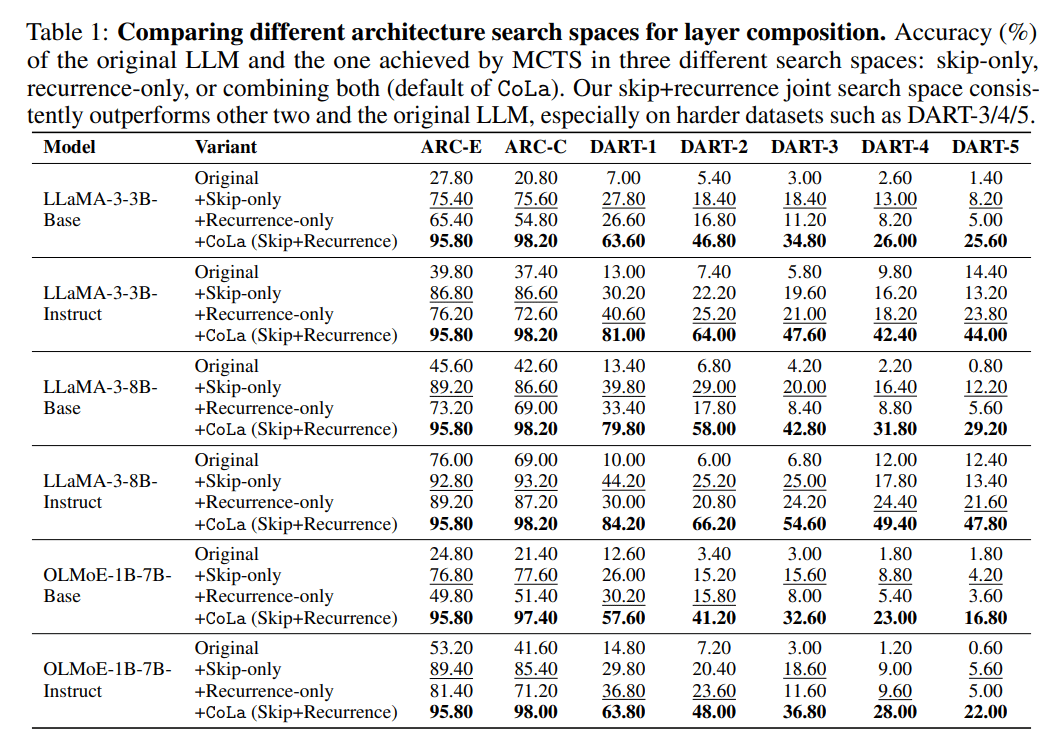

CoLa가 성능에 미치는 실제 영향

실험 결과에서 볼 수 있듯이, CoLa를 통해서 테스트-타임(Test-Time)에서 레이어를 다이나믹하게 건너뛰거나 반복하는 방식은 고정된 시퀀스를 사용하는 것보다 일관되게 더 나은 성능을 보여줬습니다. MCTS가 가이드하는 레이어 건너뛰기, 반복, 재배열을 통해서 이미 모델 안에 숨겨져 있던 성능을 끌어낼 수 있는 겁니다. 예를 들어서:

건너뛰기(Skip-only)는 간단한 작업에서 유용하고, 모델의 깊이(Depth)와 연산량을 줄입니다.

반복만 사용(Recurrence-only)하는 방식은 모델이 더 깊이 생각하도록 도와주어, 어려운 작업에서 더 나은 결과를 낼 수 있습니다.

두 가지의 방식을 함께 사용하면 입력의 난이도에 맞춰서 모델의 깊이를 조정할 수 있고, 재학습을 하지 않고서도 어려운 작업에서 최대 3배의 정확도 향상을 달성합니다.

Image Credit: CoLa 오리지널 논문

또 다른 중요한 시사점이 있는데, 이겁니다:

모델 구성의 효과적인 재구성: CoLa는 전체 사례의 75% 이상에 해당하는 경우에, 여전히 정답을 내 주면서도 더 짧은 경로를 찾아내는 경우가 많습니다.

특히, 잘못된 답을 고치는 데 '더 많은 레이어가 아니라 더 적은 레이어면 충분한 경우가 많습니다. 잘못된 답을 수정하는 경우의 60% 이상의 경우에서, 레이어 배열을 더 잘 조정하는 것이 실수를 수정하는 좋은 방법이라는 점을 확인할 수 있습니다.

대형 모델과 소형 모델의 작동 방식 차이

어려운 작업의 경우에, 그리고 대형 모델인 경우에 레이어를 좀 더 균등하게 사용합니다. 예를 들어서 파라미터 수가 8B인 대형 모델은 더 다이나믹하게 적응합니다.

소형 모델은 중간 레이어에서 더 강한 가지치기(Pruning)를 하는 성향을 보입니다. 소형 모델은 항상 특정한 레이어를 건너뛰는 등 고정된 패턴에 의존하는 경우가 많습니다.

CoLa는 수학 및 상식 추론 벤치마크에서, 그리고 일반적인 모델 및 Instruction-Tuned 모델 모두의 경우에서 좋은 성능을 보여주었습니다.

그렇지만, CoLa 기법에는 여전히 몇 가지 한계가 있습니다:

MCTS는 연산 비용이 큽니다. 추론 단계에서 비용과 시간이 많이 들 수 있고, 특히 실시간(Real-Time) 또는 대규모의 배포 환경에서는 모델을 여러 번 실행해야 하기 때문에 더 부담이 됩니다.

CoLa가 전역 최적(Global Optimal)의 실행 경로를 반드시 찾는다는 보장은 없습니다.

이 방법은 최대 LLaMA-3 8B 모델과 중간 길이의 추론 작업에 대해서 평가를 했지만, 레이어 수가 훨씬 많은 예를 들어 70B+ 모델이나 아주 긴 컨텍스트에서 얼마나 잘 스케일링이 되는지는 불분명합니다.

CoLa는 레이어 순서를 변경하지만, 레이어 간 출력을 결합하거나 더 복잡한 재라우팅(Re-routing)을 수행하지는 않습니다.

비전(Vision), 대화(Dialogue), 멀티모달(Multimodal) 작업에서 얼마나 잘 작동하는지에 대해서는 아직 정보가 없습니다.

종합적으로 볼 때, CoLa는 테스트-타임의 아키텍처 어댑테이션(Test-Time Architectural Adaptation)을 통해서 테스트 타임에서 모델의 일반화를 구현해 내는 흥미로운 새로운 방법을 제안하는 거라고 볼 수 있습니다. 그리고 또 ‘고정되어 있는’ LLM 아키텍처 때문에 성능에 제한이 있을 수 있다는 걸 입증하는 것이기도 합니다.

여기서 핵심은, 재학습된 레이어가 단순한 고정 파이프라인이 아니라 모듈형 추론 도구(Modular Reasoning Tools)처럼 작동할 수 있다는 점입니다. 모델이 사용되는 레이어와 그 방식을 다이나믹하게 조정할 수 있다면, 추가 학습이 없이도 더 빠르고, 효율적이고, 심지어 더 정확해질 수 있다는 거죠.

AI 영역에서 또 하나의 아주 흥미로운 발전 분야, 바로 모델이 ‘실제 세계’를 더 잘 이해하게끔 가르치는 것입니다. 기본적으로, 월드 모델(World Models)은 세상이 어떻게 작동하는지를 시뮬레이션하고, 주어진 환경에서의 행동이나 시점의 변화에 따라서 다음에 무슨 일이 일어날지를 학습해 예측합니다.

그렇다면, 테스트-타임 스케일링의 개념을 이런 종류의 모델에 접목하면 어떻게 될까요?

월드 모델·VLM·테스트-타임 스케일링의 만남

매사추세츠 대학교 애머스트 캠퍼스, 마이크로소프트 리서치, JHU, HKUST, 그리고 하바드의 연구자들은 최근 연구 ‘Test-Time Scaling with World Models for Spatial Reasoning’에서 다음과 같은 아이디어를 제시했는데요. 바로, 테스트 타임(Test-Time)에서 2D 이해(Understanding)에 3D 이해 능력, 즉 공간 지능(Spatial Intelligence)을 추가하는 겁니다.

이 아이디어는 MindJourney라는 특별한 테스트-타임 프레임웍(Test-Time Framework)으로 이어졌는데요:

MindJourney는 어떻게 작동하는가?

핵심을 먼저 이야기한다면, MindJourney는 비전-언어 모델(Vision Language Model, VLM)과 비디오 기반 월드 모델(Video-based World Model)을 결합하게 됩니다.

VLM은 고수준의 추론과 언어 이해를 담당하지만, 이미지를 2D로만 ‘볼’ 수 있고 3D 추론에는 약점이 있습니다.

월드 모델(World Model)은 3D 시각 시뮬레이션을 담당하는데, 장면을 여러 각도에서 바라보는 방식을 시뮬레이션해서 모델이 사람이 하듯이 추론할 수 있게 해 줍니다.

MindJourney의 목표는 기존이 VLM을 재학습하지 않아도 3D 공간 추론(Spatial Reasoning) 능력력이 향상될 수 있도록 하는 겁니다. MindJourney는 기존의 VLM에 재학습 없이 추가할 수 있습니다. 이런 협업 구조로, 전체적인 시스템은 3D 공간을 이해해야 하는 작업에서 훨씬 더 뛰어난 성능을 발휘할 수 있는 것이죠.

아래에 MindJourney의 단계별 파이프라인 작동 방식을 소개합니다:

Image Credit: MindJourney 파이프라인, MindJourney 오리지널 논문

입력(Input): “오른쪽으로 돌면 물체 뒤에 뭐가 있어?” 같은 공간적인 질문, 그리고 이미지 한 장을 줍니다.

단계별 탐색(Step-by-step Search):

검색용 VLM(Search VLM)이 짧은 움직임을 제안합니다. 예를 들어, “앞으로 0.2m 이동, 왼쪽으로 30° 회전”, “왼쪽으로 회전”, “앞으로 걷기” 등이요.

월드 모델(World Model)은 비디오 디퓨전(Video Diffusion)을 기반으로 해서, 한 장의 이미지와 방금 계획된 카메라 움직임을 입력으로 받아서 새로운 관점에서 장면이 어떻게 보일지를 그려낸 짧은, 상상의 비디오 프레임(Imagined Video Frame)을 생성합니다. 즉, 정적인 2D 이미지를 모델이 탐색할 수 있는 가상 3D 환경으로 바꿔 주는 겁니다.

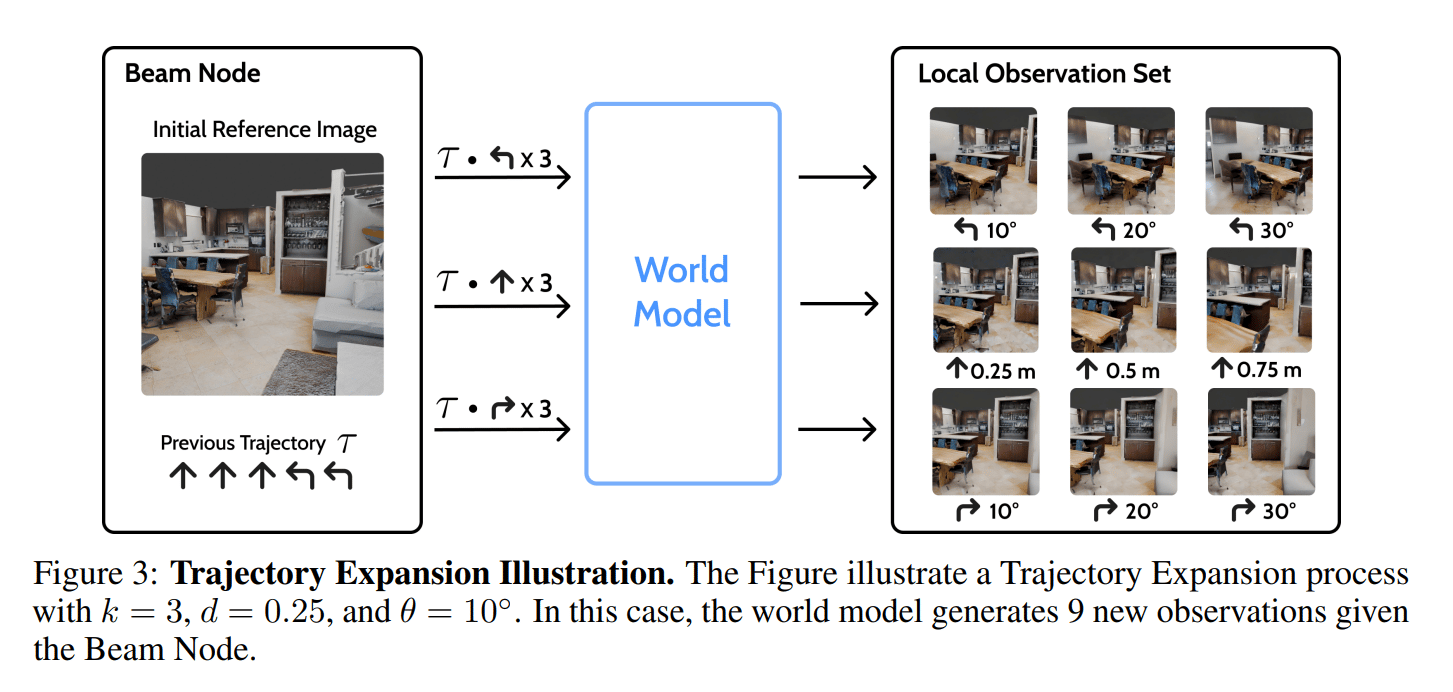

그런 다음 시스템이 Spatial Beam Search, 즉 계획 루프 단계로 들어갑니다. 탐색의 각 단계에서 VLM은 지금까지 고려해 온 모든 이동 경로 집합(빔; Beam)을 분석합니다. 각 빔 노드(Beam Node)는 더 작은 액션들을 덧붙인 새로운 궤적(Trajectory)을 시도하면서 확장됩니다.

현재 빔 노드의 각 궤적마다, 월드 모델이 해당 관점의 뷰(Views)를 생성합니다.

VLM은 각각의 새로운 뷰(View)가 얼마나 쓸모있는지를 아래 두 가지 기준으로 평가하고, 이 과정을 몇 차례 걸쳐 이어가면서 유용한 Viewpoint들의 지도를 만들어 갑니다:

“이 궤적(Trajectory)을 계속 탐색하는 것이 얼마나 유용한가?”

“지금 당장 질문에 답하는 데 이 뷰가 얼마나 유용한가?”

Image Credit: MindJourney 오리지널 논문

최종 답변(Final Answer): 유용한 뷰들을 수집한 후에, 질의응답용 VLM(Question-Answering VLM)이 원래 이미지, 그리고 유용하다고 판단된 상상의 뷰(Imagined Views)를 함께 받아서 최종 답변을 생성합니다.

여기서의 핵심은, 이 모든 과정이 테스트 타임(Test-Time)에 이루어진다는 점입니다!

‘상상(Imagine) → 선택(Select) → 답변(Answer)’이라는 루프가, VLM 자체는 고정(Fozen; 변화하지 않는다는 뜻)된 상태임에도 불구하고 MindJourney에 강력한 성능을 부여합니다.

이 프레임웍을 사용하면, VLM이 마치 사람이 공간에서 방향을 틀거나 걸어가면서 머릿속으로 시각화를 하듯이, 새로운 관점을 가상으로 탐험할 수 있게 됩니다.

그렇다면, 이 테스트-타임 스케일링의 접근법이 VLM에 실제로 얼마나 효과적일까요?

MindJourney의 성능 결과

MindJourney를 다양한 3D 공간 추론(Spatial Reasoning) 과제를 포함한 SAT 벤치마크에서 테스트한 결과는 꽤 인상적입니다:

평균 8.1% 정도 성능이 향상되었고, 일부 과제에서는 그 수치가 최대 15%까지 이릅니다.

자기중심적 움직임(Egocentric Motion), 객체 움직임(Object Motion), 행동의 결과(Action Consequences), 관점의 전환(Perspective Shifts), 목표 지향적 내비게이션(Goal-directed Navigation) 등 5가지 모든 공간 추론 유형에서 정확도가 높아졌습니다.

Image Credit: MindJourney 오리지널 논문

MindJourney는 다양한 VLM 백본과 두 가지 유형의 디퓨젼 기반 월드 모델(Diffusion-based World Model)에서 모두 잘 작동했습니다: 하나는 연구팀이 직접 제작한 SWM(Search World Model)이고, 다른 하나는 최첨단의 비디오 디퓨젼 모델, SVC(Stable Virtual Camera)입니다.

심지어 o1처럼 강화학습(Reinforcement Learning)으로 학습된 모델보다도 성능이 더 나았습니다.

강점과 한계

아래에 MindJourney의 장점을 쭉 한 번 정리해 봤습니다:

MindJourney의 ‘플러그 앤 플레이(Plug-and-Play)’ 접근 방식은 단순하지만 강력한 성능을 보여줍니다.

VLM을 재학습하지 않아도 잘 작동합니다.

기존의 어떤 VLM에도 적용할 수 있습니다.

MindJourney는 o1처럼 강화학습으로 학습된 모델도 더 향상시킬 수 있습니다. 모델이 상상한 3D 환경에 접근할 수 있도록 하면, RL만으로는 할 수 없는 수준까지 추론 능력을 끌어올릴 수 있습니다.

그렇지만, 물론 중요한 한계점도 있습니다. MindJourney의 효과는 월드 모델(World Model)의 품질에 크게 의존합니다:

상상한 3D 경로가 입력 이미지에서 너무 멀리 벗어나면, 생성의 품질이 저하됩니다.

시각적인 증거(Evidence)가 노이즈가 많으면, VLM의 의사결정에 부정적인 영향을 미칠 수 있습니다.

더 긴 롤아웃(Roll-out)을 수행하려면, 강력한 기하학적 일관성(Geometric Consistency)을 갖춘 더 나은 비디오 생성 모델이 필요합니다.

MindJourney는 테스트-타임 스케일링(Test-Time Scaling)이 특히 제어 가능한 비디오 기반 월드 모델(Controllable Video-based World Model) 같은 강력한 도구와 결합할 때, VLM의 성능을 극적으로 끌어올릴 수 있다는 완벽한 사례로, 테스트-타임 스케일링이 모델의 능력을 2D에서 3D로 확장하는 방식에 있어서 큰 변화라고 할 수 있습니다.

MindJourney에서 연구자들은 디퓨젼 기반 월드 모델(Diffusion-based World Model)을 사용했습니다. 하지만 테스트-타임 스케일링과 디퓨젼(Diffusion)이 함께 작동하는 방식에는 더 흥미로운 점이 있습니다. 두 개념 모두 정제 과정(Refinement Process) - 즉, 결과물을 한 번에 완성하는 대신 반복적으로 수정·보완하면서 점점 품질을 높여가는 방식 - 과 밀접하게 연결되어 있기 때문인데요. 그래서, 이 아이디어를 더 깊이 탐구한 구글의 최신 딥 리서처(Deep Researcher)를 꼭 한 번 살펴봐야 합니다.

구글 클라우드의 테스트-타임 디퓨전 딥 리서처(TTD-DR)

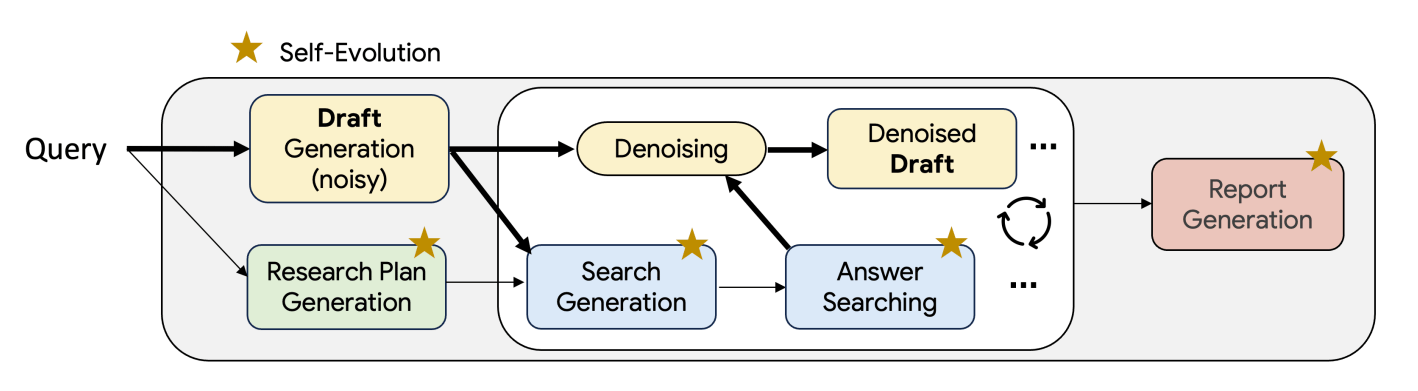

테스트-타임 디퓨전 딥 리서처(Test-Time Diffusion Deep Researcher, TTD-DR)는 장문의 연구 보고서 생성(Long-form Research Report Generation)을 반복적인 정제 과정(Iterative Refinement Process)으로 다루는 테스트-타임(Test-time) 프레임웍입니다. ‘반복적’이라고 말씀드린 건, 당연히 모든 내용을 한 번에 만들어내는 게 아니라, 사람이 연구를 진행하는 방식과 비슷하게 초안 작성(Draft) → 검색(Search) → 수정(Revise) → 반복(Repeat)의 루프를 거친다는 거죠.

TTD-DR은 출력물을 점진적으로 개선하기 위해서 추론(Inference) 단계에서만 추가적인 연산을 하는데요. 구체적인 작동 방식을 조금 더 살펴보죠.

TTD-DR의 워크플로우

TTD-DR은 기본적으로 연구 작성(Research Writing)을 일종의 디노이징(Denoising) 과정으로 간주하는데요, 아래의 단계로 진행됩니다:

Image Credit: TTD-DR 오리지널 논문

보고서 구조를 계획(Planning the Structure of the Report):

전용 LLM 에이전트가 사용자의 질의(Query)를 기반으로 구조화된 연구 계획을 수립하는데, 이는 어떤 질문에 답해야 하는지를 개요로 제시하면서 다음 단계의 방향을 잡아줍니다.에이전트는 원래 질의, 연구 계획, 그리고 이전 문맥(Context)을 활용해서 검색용 질문(Search Question)을 생성합니다.

LLM의 현재 지식을 사용해서 초기 드래프트(Draft)를 작성합니다. 이 단계의 초안은 다소 노이즈가 많고 불완전할 수 밖에 없죠.

TTD-DR은 초안, 그리고 계획에 기반해서 정보를 검색(Search)합니다.

단계별 디노이징(Denoising the Draft Step-by-Step): 에이전트가 검색된 외부 정보(Retrieval)를 통해서 확보한 새로운 정보를 사용해서 초안을 점진적으로 개선합니다.

이 루프, 즉 “검색(Search) → 업데이트(Update) → 정제(Refine) → 반복(Repeat)”을 여러 번 수행합니다. 모든 질문–답변 쌍과 계획을 수집한 후에, 에이전트가 최종적으로 일관적인 보고서를 작성합니다.

TTD-DR은 위에서 설명한 모든 단계를 향상시키기 위해서 자기 진화(Self-evolution) 시스템을 사용합니다.

이미 언급했듯이, 이 모든 과정이 테스트 타임(Test-Time)에 이루어지기 때문에 TTD-DR에 추가 학습은 필요없습니다.

TTD-DR이 Adaptive하게 작동하게끔, 그리고 자기 성찰(Self-Reflection)을 할 수 있게 하는 두 가지의 핵심 구성 요소가 있습니다.

검색 기반 디노이징(Denoising with Retrieval)

이 기능은 보고서 수준의 디노이징(Report-level Denoising)을 수행하는 데 도움을 줍니다. 초기 초안을 생성한 후에, 각 단계에서 TTD-DR은 보고서에 누락된 부분을 기반으로 해서 새로운 검색 질문(Search Question)을 생성합니다. 그 다음 온라인이나 지식 베이스(Knowledge Base)에서 관련 문서를 검색하고(Retrieve), 해당 정보를 바탕으로 답변을 만든 후에, 이 새로운 정보를 사용해서 초안을 정제(Refine)해 가면서 새로운 인사이트를 추가하거나 오류를 수정합니다.

이 루프를 여러 차례 반복하면서, TTD-DR이 최종적으로 완전한 “디노이즈된(Denoised)” 보고서를 완성할 때까지 계속 진행합니다. 진행 과정에서 초안을 지속적으로 업데이트하면서, 발견되는 새로운 정보에 맞춰 내용을 적응(Adapt)시키는 겁니다.

Image Credit: TTD-DR 오리지널 논문

컴포넌트별 자기 진화(Component-wise Self-evolution)

두 번째 구성 요소는 계획(Planning), 질문(Questioning), 답변(Answering), 작성(Writing)과 같이 에이전트의 워크플로우 각 단계를 정제하고, 독립적으로 최적화합니다. 작동 방식은 아래와 같습니다:

Image Credit: 컴포넌트별 자기 진화, TTD-DR 오리지널 논문

‘출력값의 변형(Variants)’을 여러 개 생성합니다. 예를 들어서, 하나의 질문에 대해서 여러 개의 답변을 만드는 식이죠.

각각의 ‘변형’을 판단 모델(Judging Model) 또는 자동 평가기(Auto-Rater)를 사용해서 점수화하고 비평합니다. 이때 유용성(Helpfulness), 관련성(Relevance), 정확성(Accuracy) 등을 평가합니다.

그 다음, 에이전트는 피드백을 기반으로 각 ‘변형’을 수정(Revising)합니다.

마지막으로, 가장 좋은 부분들을 병합(Merging)해 최종 버전을 만듭니다.

이 자기 진화(Self-Evolution) 과정은 각 컴포넌트의 내부에서 이루어지고, 그러면서 시간이 지날수록 시스템의 모든 부분이 더 똑똑하고 신뢰성 있게 되게끔 만들어 줍니다. 이런 방식으로 다단계 추론(Multi-hop Reasoning) 체인에서 발생할 수 있는 정보의 손실을 방지하고, 더 나은 최종 보고서를 만들어내는 겁니다.

이 두 가지 과정 — 초안 정제(Draft Refinement)와 컴포넌트별 자기 개선(Component-wise Self-improvement) — 이 서로 잘 결합되면서, 에이전트의 성능을 모든 수준의 추론에서 동시에 강화하게 된다는 겁니다.

TTD-DR이 다른 리서처보다 뛰어난 이유

성능 결과 수치를 기준으로, TTD-DR은 기존의 딥 리서치(Deep Research) 에이전트들을 능가하는 수준을 보여주고 있습니다.

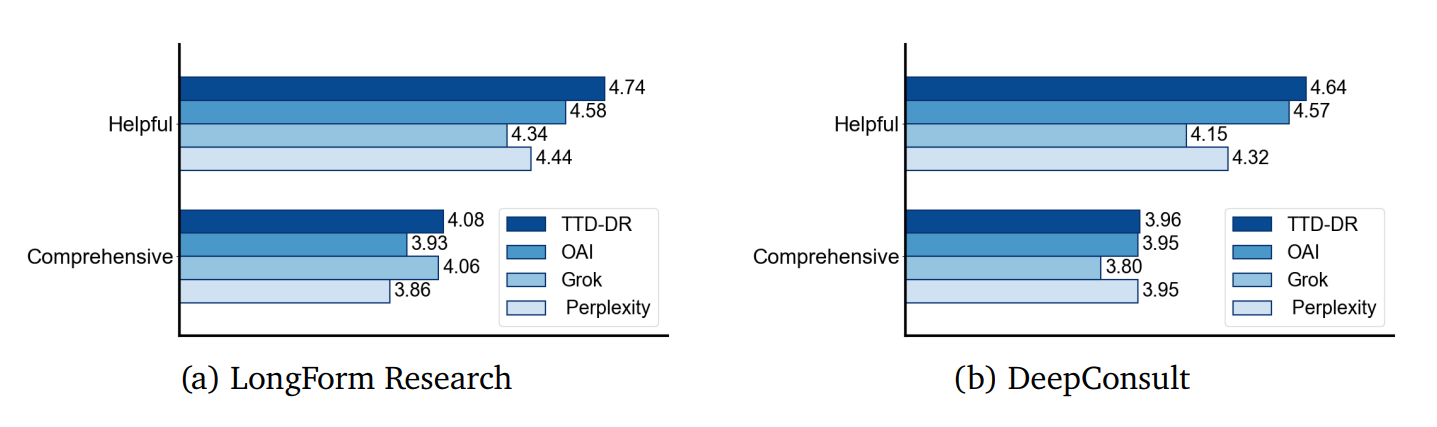

장문 연구(Long-Form Research) 작업에서, OpenAI Deep Research, Grok, Perplexity Deep Research 에이전트, Gemini-2.5를 아래와 같이 앞섰습니다.

LongForm Research 데이터셋에서 69.1% 승률(Win Rate)

DeepConsult 데이터셋에서 74.5% 승률(Win Rate)

Image Credit: TTD-DR 오리지널 논문

짧은 답변(Short-Answer) 벤치마크(HLE-Search, HLE-Full, GAIA 등)에서도, TTD-DR은 OpenAI Deep Research와 Gemini-2.5 모델 대비 정답률(Correctness) 향상 등 ‘측정 가능한’ 수준으로 성능이 개선되는 모습을 보여주었습니다.

Image Credit: TTD-DR 오리지널 논문

그럼, TTD-DR의 장점을 한 번 요약해 볼까요?

장점과 과제

다음은 TTD-DR의 장점입니다:

사람이 글을 쓰는 방식을 모방합니다. 한 번에 끝내지 않고, 계획(Planning), 피드백(Feedback), 수정(Revision)을 거치면서 작성합니다. 작업을 분리된 섹션으로 나누기만 하지 않고, 전체를 아우르는 전역(Global)적인 작성 과정을 가집니다.

진화하는 초안(Evolving Draft)이 계속해서 일관성을 유지합니다. TTD-DR은 시작 단계에서만 검색하고 실질적인 피드백 루프가 없는 시스템과는 다르게, 매 단계마다 새로 검색된 정보를 즉시 통합합니다. 그렇게 해서, 글의 정확성과 문맥적 풍부함을 유지합니다.

모듈형(Modular)이고 업그레이드 가능합니다. 계획, 답변, 작성 등 각 단계를 자기 진화(Self-evolution)를 통해서 독립적으로 개선할 수 있습니다.

자기 진화 메커니즘으로 다양한 검색 질문(Search Question)과 답변을 장려합니다.

웹 브라우저나 멀티모달 입력 같은 추가 도구가 없어도, 표준 LLM + 검색만으로도 유의미한 성능 향상을 달성하는 모습을 보여줍니다.

연산(Compute) 대비 성능이 좋습니다. 품질과 지연 시간(Latency) 간의 균형이 잘 맞는 편이고, 처리 시간이 길어지더라도 성능 향상이 더 크게 나타납니다.

전적으로 테스트 타임(Test-Time)에서 동작하고, 모델 파인튜닝(Fine-tuning)이 필요 없습니다.

물론, 한계도 있습니다:

도구 사용의 제한: 검색 도구만 사용하는 점은 장점이기도 하지만, 실제로는 웹 브라우징이나 코딩 도구 등 다른 유용한 도구를 ‘아직은’ 지원하지 않습니다.

TTD-DR은 테스트 타임 전략만 사용하기 때문에, 특정한 작업(Task)이나 도메인에 맞춰 파인튜닝하거나 적응(Adaptation)을 하지는 않습니다.

이렇게 해서, 우리가 살펴본 세 가지 연구 모두가 다양한 테스트 타임 스케일링(Test-Time Scaling) 전략이 성능 및 구조적인 개선을 크게 이끌어낼 수 있다는 걸 보여주는데요, 이건 현재 시점 AI 분야에서 어떤 연구와 개선이 빠르게 일어나고 있는지 살펴볼 수 있는, 한 단면이라고 할 수도 있겠습니다.

그렇지만, 당연하게도 테스트-타임 스케일링이 모든 작업에 완벽한 해법은 아니겠죠. 거꾸로, 테스트-타임 스케일링 전략이 오히려 역효과를 내는 경우를 살펴본 중요한 연구가 있습니다.

테스트-타임 스케일링이 빛을 발하지 못하는 5가지 순간

2025년 중반에 연구 커뮤니티가 얻게 된, 중요한 결론 중 하나는, 바로 ‘더 긴 추론(Longer Reasoning)이 항상 도움이 되는 것은 아니다’라는는 점입니다. 일부의 경우에는 나타난 문제를 수정하기보다 잘못된 추론 패턴을 강화하기도 한다는 겁니다.

이건 Anthropic, Constellation, Scale AI, University of Edinburgh 연구자들이 최근 발표한 “Inverse Scaling in Test-Time Compute” 연구에서 발견한 내용인데요: 추론 길이(Reasoning Length)가 길어질수록 정확도(Accuracy)가 오히려 떨어지는, 이른바 역스케일링(Inverse Scaling) 사례를 확인했다는 겁니다.

추론을 더 많이 하면 오히려 산만함이 커집니다. 모델은 프롬프트의 모든 문맥을 쓰려고 오래 “생각”하다가, 무관한 정보를 중요한 것으로 취급하는 경향이 있습니다. 예를 들어서 “사과 하나와 오렌지 하나가 있다. 과일은 몇 개인가?”처럼 쉬운 질문에, 중간에 무작위 코드 조각·확률·방정식 같은 무관한 세부 정보를 숨겨 넣으면, 추론이 길어질수록 Claude Opus 4와 DeepSeek-R1조차 주의가 산만해졌습니다. OpenAI o3 같은 모델은 산만해지지는 않았지만 대신 문제 문구에 딱 맞춰서 과적합(Overfitting)되어 경직되는 모습을 보였습니다.

익숙해 보이는 문제는, 실제로 묻는 바와 달라도 외운 해법을 자동으로 끌어내게 만듭니다.

제로샷(Zero-shot)과 퓨샷(Few-shot)은 중요합니다. 가이드가 없는 제로샷 설정에서는, 더 많은 “생각”이 모델을 그럴듯하지만 잘못된 상관관계로 끌고 갑니다. 반면에 8~16개 정도의 예시만 줘도 모델이 올바른 특징에 집중하도록 돕습니다.

모든 모델은 자연스러운 “생각 모드”—스스로 추론 길이를 정하는 모드—에서 더 고전을 했습니다. 일관성이 없고 혼란스러운 경로까지, 너무 많은 경로를 탐색하느라 예산을 낭비했습니다. 제브라 퍼즐(Zebra Puzzles) 실험에서 이런 현상이 확인됐고, 가장 어려운 8×8 퍼즐에서 Claude Opus 4와 OpenAI o3처럼 드물게만 추가 생각이 더 나은 답으로 이어졌습니다.

안전성 이슈: 추론 길이가 늘수록 Claude Sonnet 4의 “안전한 응답” 비율은 60% → 47%로 떨어졌습니다. DeepSeek-R1은 안정적이었고, OpenAI o3는 72% → 76%로 소폭 개선됐습니다. 따라서 잠재적인 안전성 문제에도 더 주의를 기울여야 합니다.

이렇게 보면, 테스트-타임 컴퓨트(Test-Time Compute)를 키울수록, 모든 모델이 종종 올바른 추론을 잘못된 상관관계로 대체한다는 점을 보여줍니다. 또 다단계의 복잡한 논리 문제에서 집중력을 유지하는 데 어려움을 겪었습니다. 따라서 테스트-타임 스케일링 전략의 효과를 높이는 작업과 병행해서, 모델을 단일한 추론 깊이가 아니라 여러 길이에서 시험해서 숨은 약점을 찾아 이해하는 것이 중요한 과제라고 하겠습니다.

맺으며

물론, 테스트 타임 스케일링(Test-Time Scaling) 이야기는 앞으로 계속될 겁니다. 어쩌면, 이 여정의 중간 지점도 아직 멀었을지도 몰라요. 확실한 것은, 테스트 타임-스케일링 패러다임을 다양한 AI의 개념과 모델, 그리고 애플리케이션에 적용하는 게 AI의 가능성을 더 넓게 확장하게 만들 수 있는 훌륭한 방법이라는 겁니다.

구글 클라우드의 TTD-DR은 테스트-타임 스케일링 + 에이전트(Agents) + 디퓨전(Diffusion)의 형태이고, MindJourney는 VLM과 월드 모델(World Models)을 스마트하게 결합해서 공간 지능(Spatial Intelligence)을 확장하는 방향이라고 생각합니다.

그렇지만, 또 한편 테스트-타임 스케일링을 과대평가하지 않고 조심스럽게 접근해야 한다고 이야기하는 연구자들의 목소리도 주의깊게 들어야 합니다. ‘Chain-of-Layers’는 컴퓨팅 자원을 효율적으로 관리하는 방법을 제시해 주지만, 한편으로 역스케일링(Inverse-Scaling) 현상은 우리에게 경종을 울리고 있습니다. 아직 풀어야 할 난제가 산적해 있고, 연구의 여정은 계속되어야 합니다.

보너스: 참고자료

Skip a Layer or Loop it? Test-Time Depth Adaptation of Pretrained LLMs

MindJourney: Test-Time Scaling with World Models for Spatial Reasoning

Revisiting Test-Time Scaling: A Survey and a Diversity-Aware Method for Efficient Reasoning

A Survey of Test-Time Compute: From Intuitive Inference to Deliberate Reasoning

Test-time Computing: from System-1 Thinking to System-2 Thinking

읽어주셔서 감사합니다. 친구와 동료 분들에게도 뉴스레터 추천해 주세요!

Reply