- Turing Post Korea

- Posts

- GPT-OSS: 오픈AI 최초의 '오픈 웨이트(Open-Weight)' 언어모델을 알아보자

GPT-OSS: 오픈AI 최초의 '오픈 웨이트(Open-Weight)' 언어모델을 알아보자

6년만에 오픈AI가 내놓은 오픈웨이트 모델, 그 안을 들여다봅시다

들어가며

이 글은 2025.8.23일에 모든 분들이 보실 수 있게 공개되었습니다. 재미있게 봐 주세요!

someday soon something smarter than the smartest person you know will be running on a device in your pocket, helping you with whatever you want.

this is a very remarkable thing.

머지않아, 당신이 아는 가장 똑똑한 사람보다 더 똑똑한 존재가 당신 주머니 속 기기에서 작동하며, 당신이 원하는 모든 것을 도와줄 날이 올 것입니다.

이건 정말 놀라운 일입니다.

Feels like a plot twist.

Feels like a comeback.

Feels like the beginning of something big.

이건 엄청난 ‘반전’입니다.

이건 대단한 ‘컴백’입니다.

뭔가 거대한 것의 ‘시작’입니다.

오픈AI의 샘 알트만, 그리고 허깅페이스의 CEO인 Clem Delangue이 각각 GPT-OSS의 출시와 함께 그에 대한 느낌을 표현한 게 인상적이어서 한 번 가져와 봤습니다. 어쩌면, 어제 새롭게 출시한 GPT-5와 비교해도 눌리지 않는, 또 다른 큰 의미를 가지는 GPT-OSS가 아닐까 합니다.

사실 GPT-OSS 출시와 함께 앤쓰로픽도 Claude 4.1 Opus를 공개했고, DeepMind의 월드 모델이자 시뮬레이터 Genie 3도 엄청나게 경이로웠는데도, 이번 주는 GPT-OSS, GPT-5 출시로 오픈AI가 모든 관심을 몰아간 것처럼 보입니다.

GPT-OSS는 오픈 웨이트 모델 패밀리로, 허깅페이스에서 #1 트렌딩 모델 자리를 차지했구요.

아시다시피, 지난 1년 간 ‘오픈소스 AI’ 영역은 사실상 중국의 판이었죠 - Qwen, DeepSeek, Moonshot AI 같은 중국 연구소들이 오픈소스 전략으로 확실하고 강력한 선두 주자의 하나로 자리매김했습니다:

그렇기 때문에 더더욱, 오픈AI가 이 ‘오픈소스’라는 무대에 등장한 건 큰 의미가 있다고 봅니다. 오픈AI는 허깅페이스와 지난 6개월 간 조용히 협업해 왔다고 알려져 있는데요, 그 협업 끝에 GPT-OSS 계열의 강력한 모델 2개를 공개했습니다.

개인적으로는 우선, 오픈AI가 마침내 회사 이름에 들어있는 ‘Open’이라는 단어에 걸맞는 행동을 했다는 건데, 특히 이런 오픈AI의 변화가 마찬가지로 ‘폐쇄형 모델’ 정책을 고수하고 있는 다른 미국 기업들에게 하나의 모범 사례(?)가 될 수 있기 때문입니다.

다만, 커뮤니티 내에서는 이 ‘변화’의 이면에 복잡하고 치밀한 전략이 숨어 있다는 다양한 의견이 분분하기는 합니다. 제가 보기에는 뭐 당연한 것이긴 하죠. 어쨌든, 과연 이게 진정한 오픈소스의 정신으로 복귀에 가까울까요, 아니면 시장의 내러티브를 다시 장악하기 위한 전략적 승부에 가까울까요? 아니면, 개발자들을 오픈AI 생태계에 묶어두기 위한 교묘한 수단일까요? (솔직히, 이 모든 게 다 맞는 답이기는 할 겁니다 ^.^)

오늘 에피소드에서는 다음과 같은 내용을 다룹니다:

반전 포인트: 왜 지금 오픈AI가 오픈 모델을 공개할까?

허깅페이스의 CEO인 Clem Delangue의 설명에서 시작하죠. 여섯 달 전, 샘 알트만이 파리에서 열린 AI Action Summit에서 “우리는 오픈소스에 진심입니다”라고 말했습니다.

Paris AI Action Summit에서 연설하는 샘 알트만. Image Credit: FirstPost

당시에 대부분의 사람들이 아마 이 발언을 쉽게 믿지 않았을 거예요. 비영리 연구소에서 출발했지만 현재 폐쇄형 AI 영역의 거대 기업으로 자리잡은 오픈AI의 여정, 사실 이미 실리콘밸리의 논란, 전설이 되어 있죠. 마지막으로 오픈 웨이트 언어모델을 공개했던 건 GPT-2였는데, 그게 2019년 말이었던 걸로 기억합니다. AI 업계의 시간축으로 보자면 뭐 엄청나게 오래 된 일이죠.

그렇다면, 샘 알트만은 왜 마음을 바꿔먹었을까요?

몇 가지 설득력있는 이유가 있습니다: 우선, 어쨌든 그 자리는 ‘Action Summit’이었잖아요? 그리고 올 해 1월, DeepSeek-R1이 그 전까지는 오픈소스에 대해서 별 생각없던 모든 회사에 강하게 자극을 주기도 했구요. DeepSeek은 전체 CoT를 공개하고 라이센스 정책도 관대하게 설정해서, 추론 모델의 투명성, 신뢰성에 대해서 나름대로 새로운 기준이 되었다고 할 수 있죠. 그리고 곧바로, 마치 비온 뒤 죽순이 쑥쑥 크듯이, 다른 중국 모델들이 DeepSeek의 길을 따랐죠. 자, 중국이라니? 미국의 입장에서는 어쩌면 상당히 수치스러운, 당황스러운 순간이 아니었을까요? 그래서, 결국 실제 무언가 ‘행동’이 필요했던 시점이었던 겁니다.

그리고 또, ‘지정학적(Geopolitica)’ 관점이 하나 있습니다. 중국이 주도하는 흐름에 맞설 만한 강력한 미국의 오픈소스 AI 기반을 요구하는 목소리가 커지는 상황에서, 그 역할을 누가 맡을 것이냐 생각해 보면, 가장 적합한 주체가 바로 이 분야를 선도해 온 스타트업들이겠죠. 이런 회사들이 바로, 미국이 전 세계 오픈소스 경쟁에서 최전선에 남을 수 있게 확실한 쐐기를 박는 역할을 맡아야 한다고 생각하는 이해관계자가 많았을 겁니다.

하지만, 이건 혼자 할 수 있는 일은 아니죠. 게다가 오픈AI는, 솔직히 요즘 개발자들 사이에서 썩 좋은 평판을 얻고 있다고 하기는 힘든 회사였으니까요. 반면에, 허깅페이스라는 회사는, 모두가 사랑하는 회사잖아요? 당연히 오픈AI가 손을 내밀 만한 파트너였구요. AI 업계에서는 이 ‘분위기’, ‘바이브’가 중요하고, 허깅페이스는 ‘오픈소스’를 어떤 뒷배경을 가진 ‘작전’이 아니라 자발적인 ‘운동’인 것처럼 느끼게 만들 만한 바이브가 있는 회사니까요. 게다가, 허깅페이스가 유럽에 뿌리를 두고 얀 르쿤 같은 사람들의 지지를 받고 있다는 점도, 이 움직임을 주목받게끔 하는 요소였죠.

마지막으로, Nathan Lambert의 말에 따르면, 오픈AI의 이런 움직임은 ‘전략적인 초토화 전략(Scorched Earth Policy)’일 수 있다고 합니다. 강력한 오픈 모델을 공개해서, 오픈AI는 자사의 o4-mini API와 다른 경쟁사들을 잠식해 버리고, 바로 어제 출시한 GPT-5를 위해서 하위의 구간을 싹 정리해 버리겠다는 뜻일 수도 있다는 거죠 - 프리미엄 티어를 더 쉽게 선점할 수 있으니까요.

모델 살펴보기: GPT-OSS의 내부 구조

이번에 공개된 GPT-OSS는 GPT-2와 GPT-3의 기본 아이디어를 기반으로 하지만, Mixture-of-Experts(MoE) 트랜스포머 아키텍처를 적용했습니다. 즉, ‘한 번에 모델의 일부만 활성화’해서 메모리를 절약하고 학습 효율을 높인 대규모 언어 모델이라는 말이죠. 두 모델 모두 Apache 2.0 라이센스, 128k 컨텍스트 윈도우(Context Window), 그리고 전체 CoT(Chain-of-Thought)를 접근할 수 있게끔 해 줍니다.

개방성을 향한 취사 선택

제가 이해한 게 맞다면, 오픈AI는 베이스 모델은 공개하지 않았고, 대신 최종적으로 Instruction-Tuning된, 안전성 정렬(Safety-Aligned)이 완료된 버전을 공개했습니다.

이 구분이 중요한데, 베이스 모델과 학습 데이터를 공개하지 않음으로써 오픈AI는 자사의 핵심적인 지적 재산이자 경쟁 우위를 뒷받침하는 요소를 보호하고 있는 셈입니다. 굳이 비유를 해 보자면, 자동차는 주지만 자동차 제조 공장의 설계도는 주지 않는 것과 비슷하다고나 할까요? 이렇게 접근하면, 커뮤니티의 참여를 촉진하면서도, 기술의 핵심 재료에 대한 통제권은 유지할 수 있으리라 생각하는 것이죠.

결국, 절대적인, 완전한 개방은 아니고 신중한 개방을 의미하는 것이고, 수익을 내야 하는 회사의 상황을 생각할 때 충분히 이해할 만 하기도 합니다.

오픈AI가 공개한 GPT-OSS는 두 가지 버전의 모델이 있습니다:

GPT-OSS-120B

36개의 트랜스포머 레이어로 구성된 대규모 모델로, 전체 파라미터 수는 약 1,170억 개이고, 각 단계에서 토큰당 약 51억 개의 파라미터만 사용합니다. 각각의 MoE 블록에는 128개의 Expert가 포함되어 있습니다.GPT-OSS-20B

24개의 레이어로 구성된 더 작은 버전인데, 전체 파라미터 수는 약 210억 개이고, 토큰당 36억 개의 파라미터가 활성화됩니다. 각각의 블록에는 32개의 Expert가 포함되어 있습니다.

양자화(Quantization) 기법 덕분에 MoE 레이어의 크기가 줄어들었는데, 파라미터 하나 당 정밀도를 약 4.25비트로 낮췄다고 알려져 있습니다. 덕분에 GPT-OSS-120B 모델은 단일 80GB GPU에서도 효율적으로 실행할 수 있습니다. 더 작은 GPT-OSS-20B 모델은 16GB 메모리만으로도 동작하고, 물론 GPU 가속 없이 실행을 하면 성능이 느려지긴 하지만, 엣지 디바이스나 32GB RAM 용량의 노트북에서도 사용할 수 있습니다. 특히 최상급의 노트북 모델들이 로컬에서 추론을 잘 하도록 하기 위해서 약 64GB 수준의 RAM이 있다는 걸 전제로 하는 경우가 많다는 점을 생각한다면, 80GB 대 16GB라는 하드웨어 요구사항의 차이는 좀 이상하게 느껴지기도 합니다. 어쨌든, 그럼에도 불구하고, 이런 모델들은 값비싼 인프라 없이도 로컬 배포, 빠른 반복적 실험을 할 수 있도록 해 줍니다.

그럼 이제 GPT-OSS에서 채용한 MoE 아키텍처의 중요한 구성 요소를 좀 더 구체적으로 살펴보죠.

GPT-OSS의 아키텍처에는, 현대적인 모델 설계의 트렌드와 과거의 방식들이 재미있게 섞여 있습니다.

“우선 놀랍기도 하고 재미있는 건, 어텐션 메커니즘에 GPT-2 시절처럼 바이어스 유닛(Bias Unit)을 사용했다는 점입니다. 정말 흥미로워요. 그 때 이후로 이런 아키텍처를 본 적이 없거든요”

바이어스 유닛(Bias Unit)은 뉴럴네트워크 연산에서 y=Wx+b 함수에서 b처럼, 입력값 x와 관계없이 일정한 값을 더해주는 항으로, 출력 분포를 미세 조정하고 모델의 표현력을 확장하는 역할을 합니다. GPT-2까지는 어텐션 메커니즘에도 이러한 바이어스 유닛이 포함됐지만, GPT-3 이후 대규모 모델들은 파라미터를 절약하고 효율성을 높이기 위해서 이걸 제거하는 추세였죠.

Sebastian Raschka가 놀란 이유는 GPT-OSS가 최신 트렌드와는 달리 GPT-2 스타일의 바이어스 유닛을 어텐션에 다시 도입했기 때문이라고 했는데, 아마 이건 성능과 표현력을 강화하기 위한 시도가 아닐까 합니다. 최근에는 잘 하지 않는 설계 상의 선택이기는 합니다

바이어스 유닛을 사용할 때, 사용하지 않을 때의 기술적 비교표

또 뭐가 있을까요?

이 모델은 입력값을 처리할 때, 밀집(Dense) 패턴과 로컬 밴드 희소(Local-Banded Sparse) 패턴을 번갈아서 사용하는 하이브리드 어텐션 메커니즘을 적용합니다. 여기에 Grouped Query Attention(GQA)를 결합해서, 8개의 Key-Value 헤드를 쿼리 헤드들 간에 공유합니다(각 트랜스포머 레이어에는 총 64개의 어텐션 헤드가 있음). 또 회전 위치 임베딩(Rotary Positional Embeddings, RoPE)을 사용해서 최대 131,072 토큰에 이르는 빠른 추론, 그리고 Long-Context 추론을 지원합니다.

각 어텐션 블록과 MoE 블록 이전에는 RMSNorm(Root Mean Square Normalization)가 적용됩니다. 이건 평균이 아니라 입력 벡터를 그 루트 평균 제곱(RMS) 값으로 나누어서 정규화하고, 활성화 값의 스케일을 일정하게 유지해서 학습을 안정화하게 됩니다.

각 토큰마다 라우터가 상위 4명의 Expert를 선택하고, 이들의 출력을 소프트맥스 가중 라우팅으로 결합합니다.

GPT-OSS는 SwiGLU라는 비선형 활성화 함수(Non-Linear Activation Function)의 커스텀 버전을 사용하고, 아래와 같은 추가 기능을 포함합니다:

클램핑(Clamping): 출력 값의 범위를 제한해서 극단적인 활성화를 방지

잔차 연결(Residual Connection): 활성화 함수의 출력에 입력을 다시 더해서 그래디언트 흐름을 개선

이런 추가적인 변경 사항으로, 학습의 다이나믹스를 안정화합니다.

GPT-OSS는 GPT-2 및 최신 모델의 변형된 형태들처럼, Pre-LN(블록 이전에 레이어 정규화 적용) 방식을 사용합니다. 또 소프트맥스의 분모에 바이어스 항을 추가해서, 필요할 때 모델이 관련 없는 토큰을 ‘무시’할 수 있게끔 하구요.

또 하나 흥미로운 점은, GPT-OSS에서 오픈AI가 맞춤형 토크나이저(Custom Tokenizer)를 사용했다는 점인데요. 사실 꽤 많은 고급 모델들이 지금 이렇게 하고 있죠. 이 토크나이저의 이름은 o200k_harmony이고, 다음과 같은 특징이 있습니다:

BPE(Byte Pair Encoding) 기반으로, 단어를 자주 함께 등장하는 부분 단위로 쪼갬

GPT-4o, o4-mini 등에서 사용된 오픈AI의 기존 토크나이저를 확장한 버전 (이 덕분에 해당 모델들에 대해서도 더 많은 정보를 얻게 됨)

채팅 스타일 포맷과 잘 맞게끔 설계되었고, 총 201,088개의 토큰을 포함

TikToken 라이브러리를 통해서 완전히 오픈소스로 공개

GPT-OSS 패밀리의 모델들은 추론을 강력하게 잘 하고, 도구를 원활하게 잘 활용하고, 배포를 효율적으로 할 수 있게끔 설계되어서, 사전 학습(Pre-Training)과 사후 학습(Post-Training) 단계 모두 이런 능력을 어떻게 확보할 것인가에 초점을 맞추고 있습니다.

사전 학습(Pre-training)

GPT-OSS 모델들은 STEM(과학·기술·공학·수학), 코딩, 그리고 일반 지식을 중심으로 한 방대한 텍스트 전용 데이터셋에서 수조 개의 토큰을 사용해서 사전 학습되었다고 합니다(지식 컷오프는 2024년 6월입니다). 이 과정에서 특히 생물 보안(Biosecurity)과 관련된 유해하거나 민감한 콘텐츠를 제거하기 위한 필터가 적용되었구요.

가장 중요한 기술적인 세부 사항 중 하나는 네이티브 MXFP4 양자화(Quantization)입니다.

MXFP4 Quantization에 대한 설명. Image Credit: 허깅페이스

GPT-OSS에서는 모델 파라미터 중에서도 특히 규모가 큰 MoE(혼합 전문가) 레이어를 MXFP4라는 4비트 부동소수점 형식으로 처음부터 학습했습니다. 이렇게 하면 파라미터 하나당 0.5바이트만 차지하게 되어서, 일반 FP16(2바이트) 대비 메모리 사용량이 약 4분의 1로 줄어들구요.

MoE 구조는 매 토큰마다 일부의 Expert만 활성화하니까, 이 구간에서의 메모리 절감 효과가 더욱 크게 나타납니다. 또 사후 양자화가 아니라 학습 단계부터 FP4로 안정화해서, 성능을 저하시키지 않고도 용량을 상당히 절감할 수 있습니다.

결과적으로, 전체는 1,200억 파라미터급 모델이지만, 가중치와 실행에 필요한 부가 메모리를 모두 합쳐도 단일 80GB GPU에서 구동을 할 수 있게 됐습니다. 원래 같으면 여러 장의 GPU를 연결해서 샤딩해야 했을 모델을, 한 장에 담아 실행할 수 있게 만든 핵심적인 기술적 성과입니다.

사후 학습(Post-training)

사전 학습이 끝나면, GPT-OSS 모델들에 대해서 단계별 추론(Step-by-Step Reasoning)과 에이전트형 행동(Agentic Behavior)을 개선하기 위해서 오픈AI의 o3 모델과 유사한 Chain-of-Thought(CoT) 강화 학습(Reinforcement Learning)을 실행했습니다. 이 과정에서 다음과 같은 도구 사용법을 학습했다고 합니다:

웹 검색을 위한 브라우저

Python 실행 환경

개발자가 정의한 함수들

GPT-OSS를 사용할 때의 추론 수준을, 시스템 프롬프트 지시문을 통해서 낮음(Low), 중간(Medium), 높음(High)의 세 단계로 설정할 수 있습니다. 예를 들어서 "Reasoning: high"와 같이 설정하면 평균 CoT 길이와 정확도를 제어할 수 있습니다.

단, 허깅페이스의 Clem Delangue가 이야기한 ‘주의할, 생각해 볼 것’을 염두에 둘 필요는 있습니다:

“기억해야 할 게 하나 있는데, ‘Harmony’라고 부르는 새로운 형식, 그리고 출시 초기부터 몰리는 관심 때문에, 최신 오픈 모델의 추론(Inference) 작업은 결코 간단하지 않다는 것인데요. 출시 직후에 24시간 동안은 Provider들이 거의 잠도 못 자면서 대응을 하는게 보통이라서, 품질·정확도·전체적인 ‘바이브’가 일시적으로 흔들릴 수도 있다는 점을 이해해야 할 것 같습니다. “

‘Harmony’: 새로운 프롬프팅의 표준?

LLM을 다룰 때 꽤나 까다로운 문제 중의 하나로 프롬프트 템플릿(Prompt Templating)이 있죠. AI 모델에 지시할 때 일관적으로, 구조화된 방식으로 하기 위해서, 입력 프롬프트를 미리 정해진 형식과 변수 자리로 구성하는 기법인데요.

이번에 GPT-OSS 모델을 공개하면서, 오픈AI가 나름대로의 해결책을 제안하고 있어서 관심을 끌었습니다. 바로 Harmony입니다.

Harmony는 새로운 오픈소스(Apache 2.0 라이센스) 응답 포맷이예요. 오픈AI의 Responses API와 비슷해서 뭐 모방했다고 할 수도 있을 거예요. 어쨌든, 바로 여기에 오픈AI 오픈소스 전략의 핵심이 있다고 봅니다. 전체 오픈소스 생태계가 오픈AI의 유료 플랫폼과 동일한 형식의 Harmony 포맷을 채택하도록 유도해서, 오픈AI가 일종의 ‘온램프(On-Ramp)’를 구축하는 것이죠. 즉, 개발자들이 Harmony 오픈 포맷을 기반으로 툴링, 에이전트, 워크플로우 등을 구축하게 되면, 이후에 더 강력하고 멀티모달(Multimodal) 기능 등 추가적인 강력한 기능을 제공하는 오픈AI의 독점 API로 전환하거나 업그레이드하는 게 아주 쉽고 자연스러워질 거라는 겁니다.

Harmony와 관련된 오픈AI의 전략은, 플랫폼 전략의 모범 사례에 해당한다고 볼 수 있습니다. 오픈소스 진영에 기여하면서도, 동시에 오픈AI 생태계를 새로운 세대의 에이전트형 애플리케이형의 기본 선택(Default)으로 만들어갈 수 있는, 잠재적인 락인(Lock-in) 메커니즘이기도 하니까요.

더불어, Harmony는 오픈 가중치(Open-Weight)의 세계에서는 다소 새로운 개념들을 도입하기도 했습니다:

확장된 역할(Expanded Roles): 기존의 user와 assistant 외에 system, developer, tool 역할을 정의

출력 채널(Output Channels): final(사용자용), analysis(내부 사고 과정), commentary(도구 상호작용)라는 세 개의 구분된 출력 스트림 제공

강화된 특수 토큰(Robust Special Tokens):

<|call|>,<|channel|>과 같은 지시문 전용 토큰 ID를 포함한 새로운 토크나이저 o200k_harmony를 사용해서, 포맷의 견고성(Robustness)을 강화

Response AI vs. Harmony 비교

The Focus AI의 Will Schenk는 Harmony에 대해 이렇게 이야기합니다:

메시지 타입에서 system과 developer를 분리한 건, 우리가 시스템 프롬프트를 사용하는 방식을 더 잘 반영하구요. 또 출력 채널(Output Channel)의 형식화를 해서 애플리케이션이 출력 결과를 표준화하기 시작할 수 있게 해 줍니다. commentary 채널에는 도구 호출이 표시되지만, analysis 채널에서는 모델의 사고 과정(Chain-of-Thought, CoT)을 담고 있구요. 스펙에는 이렇게 명시되어 있습니다:

‘analysis 채널의 메시지는 최종 메시지와 동일한 안전 기준을 따르지 않습니다. 최종 사용자가 보지 않도록 하세요.’

Harmony는 복잡하고 에이전트형인 모델과의 소통 방식을 표준화하기 위한, 나름대로의 진지한 시도라고 봅니다. Python과 Rust 양쪽에서 렌더러를 오픈소스로 공개해서, 생태계에서 이걸 비교적 쉽게 채택할 수 있게 하고 있습니다. (그리고 자사의 유료 API로 전환하기도 쉽도록 합니다.)

일단 이 정도가, 오픈AI의 GPT-OSS에 대한 기술적인 측면에서 확인된 내용이구요. 이제, 이 모델을 실제로 테스트했을 때의 성능을 살펴보겠습니다.

실제로 어느 정도 잘 작동하나

벤치마크를 통해서 모델의 성능을 확인해 보는 것도 물론 좋지만, 진짜 제대로 된 시험은 직접 내 손을 더럽히면서 써 보는 것이겠죠.

Simon Willison이 - 언제나 그렇듯이 - 자신의 개인적인 평가 항목인 ‘Pelican on a bicycle’ 테스트를 GPT-OSS 모델에 해 봤고, 그 결과를 여기에서 확인할 수 있습니다.

Simon이 한 ‘Pelican on a bicycle’ 테스트 결과 (120B 모델 via API Provider)

Will Schenk는 아래와 같이 자기가 테스트한 감상을 공유해 주었습니다:

gpt-oss는 전반적으로 1년 전의 파운데이션 모델 비슷한 느낌이지만, 더 잘 다듬어져 있고 로컬에서 실행할 수 있는 텍스트 전용 모델 중에서는 가장 강력한 축에 속합니다. 그리고 이제 이걸 리믹스할 수 있게 된 거죠. 작은 모델들이 점점 더 강력해질 거라고 예상은 했지만, 4년 된 제 노트북에서 두 가지 공개 모델 중에 작은 모델을 실행할 수 있다는 점은 여전히 놀랍습니다.

텍스트 전용이기 때문에, 특히 Gemma 3가 잘하는 일부 사용 사례는 빼더라도, 전반적인 결과는 아주 완성도가 높다고 느껴집니다.

일반적으로 도구 사용 능력은 좋지만, 추론을 시도하다가 루프에 빠질 수 있습니다. 에이전트형 워크플로(Agentic Workflow)는 아직 완전하지 않지만 아주 좋아진 상태입니다.

로컬에서 실행하는 것 치고는 코드 작성 능력이 놀라울 정도로 좋지만, 실제로 파일을 작성하기 위해 도구를 호출하기 시작하면 성능이 떨어집니다. 20B 모델은 goose나 RooCode 같은 걸 제대로 지원할 수준은 아닙니다. Goose는 콘솔에 코드를 설계하고 작성할 수 있었지만, 파일 시스템에 실제 코드를 작성하기 위해서 도구를 호출하기 시작하자 성능이 떨어졌습니다. RooCode는 컨텍스트 윈도우를 최대한 늘려도 과제 자체를 너무 혼란스러워 했습니다.

비록 오픈AI가 실제 소스를 오픈하지는 않았지만, 적어도 이 모델들은 실행해 볼 자유, 연구할 자유, 수정할 자유를 우리에게 줍니다.

활용 분야 및 설치 방법

우선, 허깅페이스에서 접근해 보실 수 있구요.

Ollama를 통한 사용

먼저, Ollama를 다운로드하세요. 실행한 다음에, 터미널에서 모델을 내려받고 시작해 봅니다. 그 다음에 아래 명령어를 실행하세요.

ollama pull gpt-oss:20b그 다음에 다시 아래 명령어를 실행하세요.

ollama run gpt-oss:20b "why is the sky dark at night"lmstudio를 통한 사용

먼저, lmstudio를 다운로드하세요. 설치하면 안내 메시지가 표시될 겁니다.

커맨드라인이나 인터페이스를 사용할 수 있습니다.

컨텍스트 사이즈 변화에 따른 응답의 변화

일반적으로 컨텍스트 크기가 클수록, 모델이 더 많이 생각하게 된다고 할 수 있겠죠. 물론, 프롬프트를 사용해서 ‘세 가지 수준’에서 생각하게끔 요청할 수 있지만, 컨텍스트도 당연히 중요합니다.

Ollama에서의 기본 컨텍스트 크기를 확인해 보면 다음과 같습니다.

$ ollama run gpt-oss:20b

>>> /show info

Model

architecture gptoss

parameters 20.9B

context length 131072

embedding length 2880

quantization MXFP4 lmstudio의 기본값도 마찬가지라서, 컨텍스트 사이즈를 변경한 다음에 모델을 다시 로드해야 합니다.

성능의 역설: 날카롭지만 불안정한 천재인가?

이 모델의 성능에 대한 반응은 복합적이기도 하고, 복잡하게 나타나고 있는데요.

특정한 작업에서의 추론 능력은 최상급이지만, 일부 사용자들은 “환각의 축제(Hallucination Fiesta)” 수준이라고까지 할 만한 오류를 지적하거나, ‘Out-of-Distribution’ 벤치마크에서 점수가 낮다고 이야기하고 있기도 합니다.

요약하자면, GPT-OSS 모델이 보여주는 성능 프로파일이 ‘삐죽빼죽(Spiky)’하고 ‘부스러지기 쉬워 보이는(Brittle)’ 모습으로 나타난다는 거죠. 즉, 이 모델은 ‘학습된 작업’에서는 천재처럼 보이지만, 그 범위를 벗어나면 어려움을 겪는다는 겁니다. 그래서, GPT-OSS가 합성 데이터(Synthetic Data)를 활용해서 집중적으로 학습했을 거라는 광범위한 추측이 나오고 있는 겁니다. 합성 데이터를 사용하는 건, 학습 자체의 스케일을 확대하면서도 저작권 문제를 피하고 유해한 콘텐츠를 줄일 수 있게끔 해 줄 수 있는, 똑똑한 방법이죠. 하지만 단점은 과도한 최적화(Over-Optimization)로 이어져서, 벤치마크에서는 만점을 받지만 더 복잡하고 현실적인 데이터를 맞닥뜨렸을 때는 학습된 모델이 가지는 일반화를 위한 견고성(General Robustness)이 한계를 금방 드러낼 수 있다는 점입니다.

이런 의견은, GPT-OSS를 프로덕션 환경에서 고려하는 분들은 반드시 평가, 고려해 봐야 할 중요한 요소라고 하겠습니다.

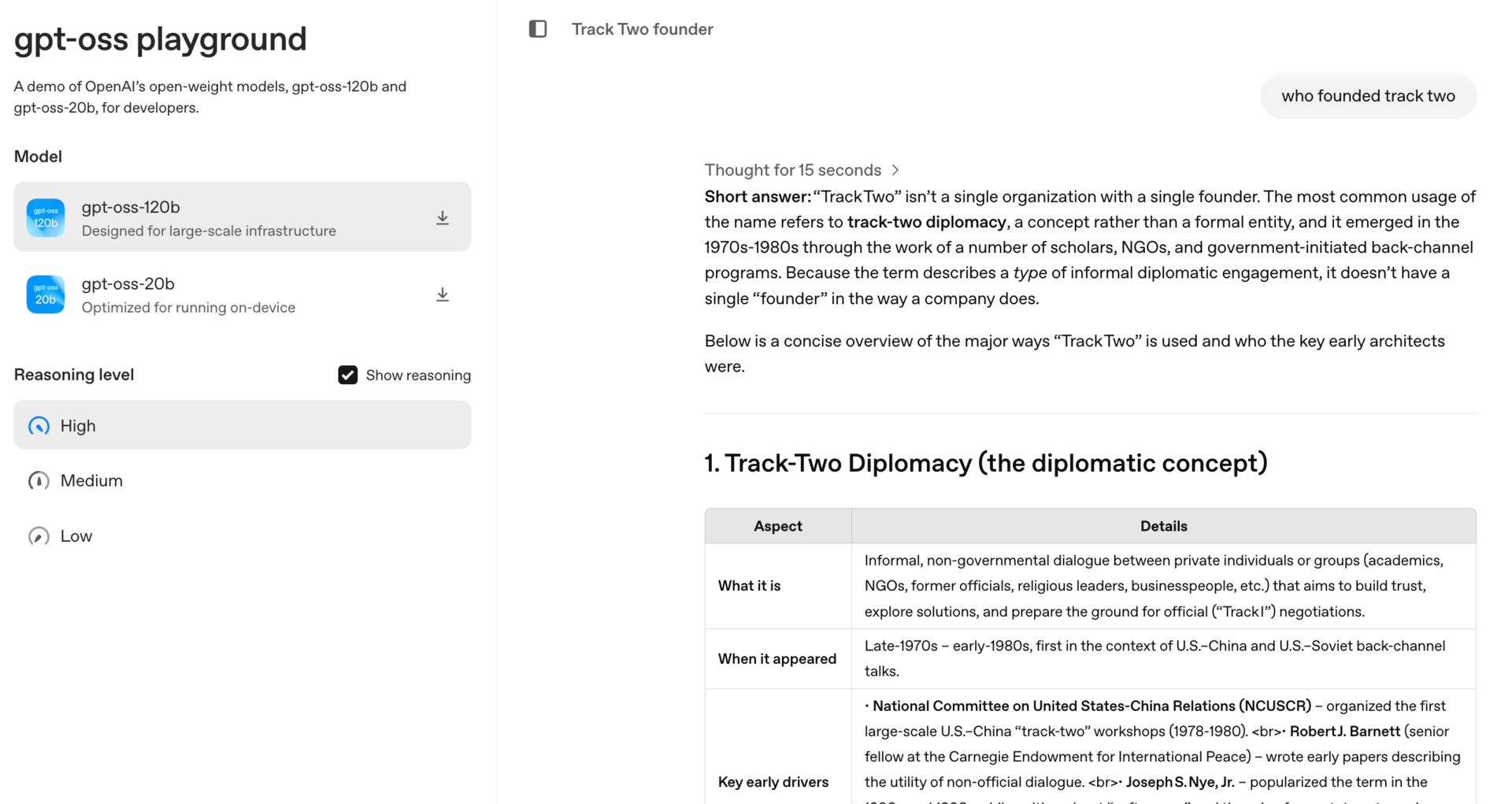

아래 그림은, GPT-OSS 모델이 완전히 잘못된 답변을 생성한 예시입니다:

위 답변하고 비교해 보기 위해서, 아래는 ChatGPT가 생성한 답변 예시입니다:

물론, Ollama를 통해서 웹 검색을 연결하는 방식으로 GPT-OSS 모델을 강화하는 건 그리 어렵지 않기는 합니다.

‘오픈소스’에서의 왕관, 과연 누구에게

그렇다면, GPT-OSS가 오픈소스 영역의 새로운 왕(King)이라고 할 수 있을까요? 그렇지는 않습니다. 하지만 오픈AI의 입장에서는 아주 중요한, 그리고 다른 회사와 조직들에 자극과 영감을 주는 한 걸음이라는 건 분명하죠.

주요한 평가들을 참고해 보면, GPT-OSS는 미국에서 나온 오픈 가중치(Open-Weights) 모델 중에서는 가장 지능적인/똑똑한 모델이라는 건 확실하지만, 순수하게 지능(Intelligence)의 측면에서 중국의 대표 모델인 DeepSeek-R1이나 Qwen3-235B를 확실히 넘어선다고 보기는 어렵습니다.

GPT-OSS의 강점은, 사실 ‘놀라운 효율성’에 있습니다. 훨씬 적은 활성 파라미터로 거의 대등한 성능을 달성하고 있으니까요.

연구 커뮤니티에서 바라보는 관점에서는, 한 가지 문제가 더 있습니다. 오픈AI는 베이스 모델을 공개하지 않았다고 말씀드렸죠. 최종적으로 완성된 모델, 즉 Instruction-Tuned 되고 안전성 정렬(Safety-Aligned)이 완료된 모델만 공개했습니다. 그래서, 연구자들이 모델을 기초부터 연구하고, 수정하고, 확장하는 것은 사실상 아주 어렵습니다. ‘진정한 오픈소스’ 커뮤니티에 속해 이는 많은 사람들에게는, 밀집(Dense)형의 베이스 모델이 가장 가치 있는 산출물이기 때문에, 이번 공개에서 그게 빠져 있다는 점은 그 자체가 상당한 한계로 작용할 수 있을 겁니다.

안전성, 레드팀 테스트, 그리고 최악의 시나리오

또 다른 한계점은 ‘안전 조치’와 관련된 겁니다. 아시다시피, 오픈AI는 이번 모델 공개 시에 ‘안전성’과 관련된 이야기를 아주 신중하게 다뤘는데요.

가장 주목할 만한 조치가 뭘까요? 바로 악의적인 파인튜닝(Fine-Tuning) 위험을 직접 평가했다는 점입니다. 공격자를 시뮬레이션하기 위해서, OpenAI는 gpt-oss-120B를 생물학(Biology)과 사이버보안(Cybersecurity) 전문 데이터로 적대적(Adversarial) 파인튜닝하고, 기본적으로 어떤 요청도 거부하지 않는 모델을 만들었다고 알려져 있는데요. 외부 전문가 검토까지 거친 결론은, 이렇게 강화된 버전마저도 오픈AI의 준비 프레임웍(Preparedness Framework)을 기준으로 했을 때 ‘높음(High)’ 수준의 재난적 위험(Catastrophic Risk) 능력에는 도달하지 못했다는 것이었습니다.

더불어 오픈AI는 50만 달러 규모의 레드 팀 챌린지(Red Teaming Challenge)를 통해서, 커뮤니티의 다양한 개발자와 관계자들이 오픈AI가 미처 찾아내지 못한 새로운 안전성 문제를 찾아내게끔 하기도 했구요.

그런데, 이런 방식으로 ‘선제적으로 안전성을 보장하겠다’는 방식은 큰 장점이 있음에도 불구하고, 반대 급부가 따르기도 합니다: 이런 접근 방식을 따르게 되면, 내장된 가드레일(Guardrail)을 파인튜닝으로 쉽게 제거하지 못하게 되고, 결과적으로 오픈AI 외부의 개발자가 실제로 확보할 수 있는 통제 범위가 아주 제한되게 됩니다. 연구 및 오픈소스 커뮤니티 일부에서는 이런 접근 방식이 ‘책임 있는 정렬(Responsible Alignment)’이라기보다는 ‘제한(Restriction)’에 가깝다고 느끼기도 한다고 합니다. 결국에, 내가 모델을 심도있게 수정할 수 없다면, 그게 개방형 연구(Open-Ended Research)에 얼마나 유용할 것인가 하는 의문이 생긴다는 거겠죠.

GPT-OSS 공식 평가 결과 (추가 평가 필요함)

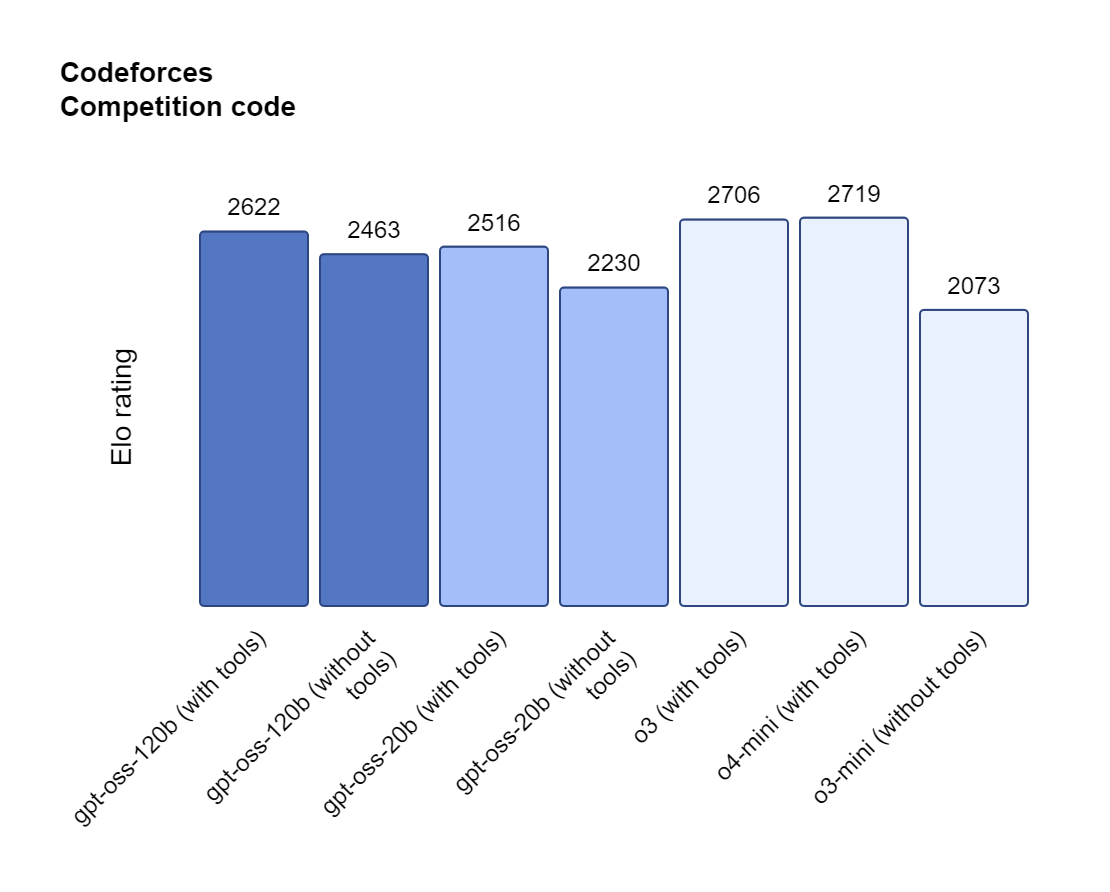

GPT-OSS 모델의 성능과 관련해서, 오픈AI는 gpt-oss-120B는 고난도 추론과 도구 사용 작업에서 o4-mini 같은 자사의 선도적인 폐쇄형 모델들과 동등하거나 그 이상을 보여준다고 주장합니다.

수학과 과학 분야에서는 AIME 2025에서 98.7%, GPQA Diamond에서 83.3%를 기록하면서, 두 지표 모두에서 o4-mini와 o3-mini를 능가했습니다.

코딩 분야에서는 Codeforces에서 o4-mini와 동일한 성능을 보여주었고, SWE-Bench에서 67.8%를 기록했습니다.

Image Credit: Introducing GPT-OSS 블로그

그리고, τ-Bench 함수 호출(Function Calling)에서 70.4%를 기록하면서 강력한 개발자 도구 사용 능력을 보여주었습니다.

의학 관련 시나리오에서는 o4-mini, GPT-4o, o3를 완전히 능가하는 모습입니다.

규모가 6배나 작은데도, GPT-OSS-20B는 여전히 괜찮은 경쟁력을 보여주는 모델이고, 대부분의 핵심적인 테스트 분야에서 o3-mini를 능가했습니다.

맺으며

자, 이번 에피소드에서는, 오픈AI가 공개한 오픈 가중치 모델, GPT-OSS의 아키텍처 기본부터 커뮤니티 반응까지 살펴봤습니다.

프로덕션급의 오픈 모델이 필요하고, 최고 수준의 추론 능력, 그리고 도구 사용 능력을 원하고, 고성능 GPU에 접근할 수 있다면, gpt-oss-120B가 효율성과 성능 면에서 미국에서 나온 새로운 최고 수준의 모델일 가능성이 높습니다.

로컬에서 코딩과 실험을 위해서 강력한 모델을 실행해 보려는 개발자라면, gpt-oss-20B는 꽤 괜찮은 모델입니다. 크기는 작지만 성능을 꽤 놀랍고, 속도도 아주 빨라서 DeepSeek보다 빠릅니다.

오픈소스 영역으로의 오프AI의 복귀, 이 이벤트가 앞으로 오픈소스 생태계에 앞으로 더 강력한 경쟁과 협력을 촉진하기를 바랍니다. 오픈AI의 모델 공개 그 자체가 물론 놀라운 전진이기는 하지만, 베이스 모델까지 공개하지 않았다는 점은 여전히 가장 가치있는 자산은 비밀에 부쳐 두었다는 점을 의미하기도 합니다.

앞으로 미국의 오픈소스 운동이 어떤 방향으로 전개될지, 미국과 중국의 경쟁은 어떻게 펼쳐질지, 그 틈새에서 우리나라와 같은 생태계는 어떻게 대응하게 될지 기대됩니다.

보너스: 참고 자료

공식 릴리즈

커뮤니티 반응과 자료

“When Sam Altman told me…” by Clem Delangue

Lots of conflicting takes about gpt-oss (yay open-source in the spotlight)! by Clem Delangue

gpt-oss: OpenAI validates the open ecosystem (finally) by Nathan Lambert

Sebastian Raschka’s tweet

OpenAI’s new open weight (Apache 2) models are really good by Simon Willison

“hallucination fiesta” thread on Twitter by Lisan al Gaib

읽어주셔서 감사합니다. 친구와 동료 분들에게도 뉴스레터 추천해 주세요!

Reply